Adaltas est une équipe de consultants experts en Open Source, Big Data et systèmes distribués. Nous sommes présents en France, au Canada et au Maroc.

- Architecture, audit et transformation digitale

- Exploitation Cloud et on-premise

- Applications complexes et chaînes d'ingestion

- Solutions optmisées et résiliantes

Articles récents

Keyser, unique script bash pour la gestion de certificats SSL

Catégories : Cybersécurité, DevOps & SRE | Tags : Bash, Cybersécurité, DevOps, Chiffrement, SSL/TLS

Keyser est un utilitaire en ligne de commande conçu pour simplifier la création, la gestion et la protection des certificats SSL de manière efficace et sécurisée. Distribué sous la forme d’un script…

Par MORCILLO Eliott

25 juin 2025

Export de Buttercup vers KeePass

Catégories : Cybersécurité | Tags : Authentification, CSV, Node.js

Buttercup est un gestionnaire de mots de passe qui fonctionne sur les systèmes Linux, macOS, Windows, iOS et Android. Le 3 mars, le principal contributeur de Buttercup, Perry Mitchell, a annoncé…

Par WORMS David

14 mai 2025

Utilisation des attributs Git

Catégories : DevOps & SRE | Tags : Git, GitOps

Les attributs Git ne sont pas un concept que l’on apprend dans les premiers temps lorsqu’on se familiarise avec Git. Même les développeurs expérimentés ne les connaissent pas toujours en raison de…

Par KUDINOV Sergei

25 janv. 2025

Méthodes pour le suivit de connection SSH

Catégories : DevOps & SRE | Tags : Bash, DevOps

Pour des besoins d’enseigmement chez Adaltas, nous fournissons des conteneurs isolés à nos étudiants. Les étudiants disposent d’une connexion SSH commune et sont redirigés vers un conteneur dédié…

Par WORMS David

11 nov. 2024

Introduction à OpenLineage

Catégories : Big Data, Gouvernance des données, Infrastructure | Tags : Data Engineering, Infrastructure, Atlas, Data Lake, Lakehouse, Entrepôt de données (Data Warehouse), Traçabilité (data lineage)

OpenLineage est une spécification open source de lineage des données. La spécification est complétée par Marquez, son implémentation de référence. Depuis son lancement fin 2020, OpenLineage est…

19 févr. 2024

Guide d'installation à TDP, la plateforme big data 100% open source

Catégories : Big Data, Infrastructure | Tags : Infrastructure, VirtualBox, Hadoop, Vagrant, TDP

La Trunk Data Platforme (TDP) est une distribution big data 100% open source, basée sur Apache Hadoop et compatible avec HDP 3.1. Initiée en 2021 par EDF, la DGFiP et Adaltas, le projet est gouverné…

Par FARAULT Paul

18 oct. 2023

Lancement du site Internet de TDP

Catégories : Big Data | Tags : Programmation, Ansible, Hadoop, Python, TDP

Le nouveau site Internet de TDP (Trunk Data Platform) est en ligne. Nous vous invitons à le parcourir pour découvrir la platorme, rester informés, et cultiver le contact avec la communauté TDP. TDP…

Par WORMS David

3 oct. 2023

CDP partie 6 : cas d'usage bout en bout d'un Data Lakehouse avec CDP

Catégories : Big Data, Data Engineering, Formation | Tags : Business Intelligence, Data Engineering, Iceberg, NiFi, Spark, Big Data, Cloudera, CDP, Analyse de données, Data Lake, Entrepôt de données (Data Warehouse)

Dans cet exercice pratique, nous montrons comment construire une solution big data complète avec la Cloudera Data Platform (CDP) Public Cloud, en se basant sur l’infrastructure qui a été déployée tout…

Par CHAVARRIA Tobias

24 juil. 2023

CDP partie 5 : gestion des permissions utilisateurs sur CDP

Catégories : Big Data, Cloud computing, Gouvernance des données | Tags : Ranger, Cloudera, CDP, Entrepôt de données (Data Warehouse)

Lorsqu’un utilisateur ou un groupe est créé dans CDP, des permissions doivent leur être attribuées pour accéder aux ressources et utiliser les Data Services. Cet article est le cinquième d’une série…

Par CHAVARRIA Tobias

18 juil. 2023

CDP partie 4 : gestion des utilisateurs sur CDP avec Keycloak

Catégories : Big Data, Cloud computing, Gouvernance des données | Tags : EC2, Big Data, CDP, Docker Compose, Keycloak, SSO

Les articles précédents de la série couvrent le déploiement d’un environnement CDP Public Cloud. Tous les composants sont prêts à être utilisés et il est temps de mettre l’environnement à la…

Par CHAVARRIA Tobias

4 juil. 2023

CDP partie 3 : activation des Data Services en environnment CDP Public Cloud

Catégories : Big Data, Cloud computing, Infrastructure | Tags : Infrastructure, AWS, Big Data, Cloudera, CDP

L’un des principaux arguments de vente de Cloudera Data Platform (CDP) est la maturité de son offre de services. Ceux-ci sont faciles à déployer sur site, dans le cloud public ou dans le cadre d’une…

Par KONRAD Albert

27 juin 2023

CDP partie 2 : déploiement d'un environnement CDP Public Cloud sur AWS

Catégories : Big Data, Cloud computing, Infrastructure | Tags : Infrastructure, AWS, Big Data, Cloud, Cloudera, CDP, Cloudera Manager

La Cloudera Data Platform (CDP) Public Cloud constitue la base sur laquelle des lacs de données (Data Lake) complets sont créés. Dans un article précédent, nous avons présenté la plateforme CDP. Cet…

Par KONRAD Albert

19 juin 2023

CDP partie 1 : introduction à l'architecture Data Lakehouse avec CDP

Catégories : Cloud computing, Data Engineering, Infrastructure | Tags : Data Engineering, Iceberg, AWS, Azure, Big Data, Cloud, Cloudera, CDP, Cloudera Manager, Entrepôt de données (Data Warehouse)

Cloudera Data Platform (CDP) est une data platform hybride pour l’intégration de donnée, le machine learning et l’analyse de la data. Dans cette série d’articles nous allons décrire comment installer…

Par BAUM Stephan

8 juin 2023

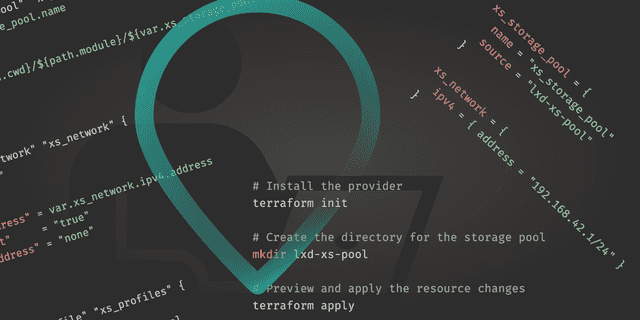

Des environnements de développement locaux avec Terraform + LXD

Catégories : Orchestration de conteneurs, DevOps & SRE | Tags : Automation, DevOps, KVM, LXD, Virtualisation, VM, Terraform, Vagrant

En tant qu’architecte de solutions Big Data et InfraOps, j’ai besoin d’environnements de développement pour installer et tester des logiciels. Ils doivent être configurables, flexibles et performants…

Par LEONARD Gauthier

1 juin 2023

Exigences et attentes d'une plateforme Big Data

Catégories : Big Data, Infrastructure | Tags : Data Engineering, Gouvernance des données, Analyse de données, Data Hub, Data Lake, Lakehouse, Data Science

Une plateforme Big Data est un système complexe et sophistiqué qui permet aux organisations de stocker, traiter et analyser de gros volumes de données provenant de diverses sources. Elle se compose de…

Par WORMS David

23 mars 2023

Déploiement de Keycloak sur EC2

Catégories : Cloud computing, Data Engineering, Infrastructure | Tags : EC2, sécurité, Authentification, AWS, Docker, Keycloak, SSL/TLS, SSO

Pourquoi utiliser Keycloak Keycloak est un fournisseur d’identité open source (IdP) utilisant l’authentification unique SSO. Un IdP est un outil permettant de créer, de maintenir et de gérer les…

Par BAUM Stephan

14 mars 2023

Gestion de Kafka dans Kubernetes avec Strimzi

Catégories : Big Data, Orchestration de conteneurs, Infrastructure | Tags : Kafka, Big Data, Kubernetes, Open source, Streaming

Kubernetes n’est pas la première plateforme à laquelle on pense pour faire tourner des clusters Apache Kafka. En effet, la forte adhérence de Kafka au stockage pourrait être difficile à gérer par…

Par SCHOUKROUN Leo

7 mars 2023

Kubernetes : déboguer avec les conteneurs éphémères

Catégories : Orchestration de conteneurs, Tech Radar | Tags : Debug, Kubernetes

Tout individu ayant eu un jour à manipuler Kubernetes s’est retrouvé confronter à la résolution d’erreurs de pods. Les méthodes prévues à cet effet sont performantes, et permettent de venir à bout des…

Par BERLAND Pierre

7 févr. 2023