Articles publiés

Export de Buttercup vers KeePass

Catégories : Cybersécurité | Tags : Authentification, CSV, Node.js

Buttercup est un gestionnaire de mots de passe qui fonctionne sur les systèmes Linux, macOS, Windows, iOS et Android. Le 3 mars, le principal contributeur de Buttercup, Perry Mitchell, a annoncé…

Par WORMS David

14 mai 2025

Méthodes pour le suivit de connection SSH

Catégories : DevOps & SRE | Tags : Bash, DevOps

Pour des besoins d’enseigmement chez Adaltas, nous fournissons des conteneurs isolés à nos étudiants. Les étudiants disposent d’une connexion SSH commune et sont redirigés vers un conteneur dédié…

Par WORMS David

11 nov. 2024

Lancement du site Internet de TDP

Catégories : Big Data | Tags : Programmation, Ansible, Hadoop, Python, TDP

Le nouveau site Internet de TDP (Trunk Data Platform) est en ligne. Nous vous invitons à le parcourir pour découvrir la platorme, rester informés, et cultiver le contact avec la communauté TDP. TDP…

Par WORMS David

3 oct. 2023

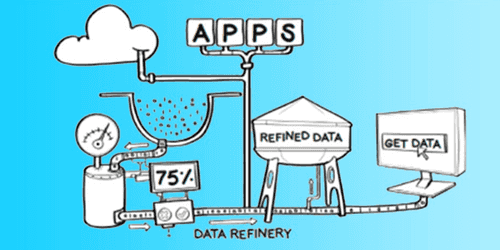

Exigences et attentes d'une plateforme Big Data

Catégories : Big Data, Infrastructure | Tags : Data Engineering, Gouvernance des données, Analyse de données, Data Hub, Data Lake, Lakehouse, Data Science

Une plateforme Big Data est un système complexe et sophistiqué qui permet aux organisations de stocker, traiter et analyser de gros volumes de données provenant de diverses sources. Elle se compose de…

Par WORMS David

23 mars 2023

Adaltas Summit 2022 Morzine

Catégories : Big Data, Adaltas Summit 2022 | Tags : Data Engineering, Infrastructure, Iceberg, Conteneur, Lakehouse, Docker, Kubernetes

Pour sa troisième édition, toute l’équipe d’Adaltas se retrouve à Morzine pour une semaine entière avec 2 jours dédiés à la technologie les 15 et 16 septembre 2022. Les intervenants choisissent l’un…

Par WORMS David

13 janv. 2023

Traefik, Docker et dnsmasq pour simplifier la mise en réseau des conteneurs

Catégories : Orchestration de conteneurs, Infrastructure, Tech Radar | Tags : DNS, Gatsby, JAMstack, Linux, Docker, Réseau

Les bonnes aventures technologiques commencent par une certaine frustration, un besoin ou une exigence. C’est l’histoire de la façon dont j’ai simplifié la gestion et l’accès de mes applications Web…

Par WORMS David

17 nov. 2022

Création de package Nix : installation d'une police non disponible

Catégories : Hack | Tags : Enseignement et tutorial, Linux, Packaging, GitOps, NixOS, Open source

La collection de packages Nix est importante avec plus de 60 000 packages. Cependant, il y a de fortes chances que parfois le package dont vous avez besoin ne soit pas disponible. Vous devez…

Par WORMS David

29 mars 2022

JS monorepos en prod 6 : CI/CD, intégration et déploiement continue avec Travis CI

Catégories : DevOps & SRE, Front End | Tags : CI/CD, Monorepo, Node.js, Tests unitaires

La mise en place d’une intégration continue (CI) et d’un déploiement continu (CD) sur un monorepo est assez complexe en raison de la diversité des responsabilités entre les développeurs et de la…

Par WORMS David

6 déc. 2021

Stage de fin d'étude printemps 2022 - construction d'un Data Lab

Catégories : Data Science, Formation | Tags : Spark, Argo CD, Elasticsearch, Internship, Keycloak, Kubernetes, MongoDB, OpenID Connect, PostgreSQL

Descriptif du stage Au cours des dernières années, nous avons développé la capacité d’utiliser les ordinateurs pour traiter une grande quantité de données. L’écosystème a évolué vers une offre étendue…

Par WORMS David

24 nov. 2021

Version 6 du package CSV pour Node.js

Catégories : Node.js | Tags : Data Engineering, Refactoring, CSV, Format de fichier, Versions et évolutions

La dernière version du package pour Node.js vient d’être publiée ainsi que celles de ses sous-projects. Voici les versions publiées : version , précédente version NPM version , précédente version…

Par WORMS David

15 nov. 2021

Stage de fin d'étude printemps 2022 en Data Engineering

Catégories : Front End, Formation | Tags : Métriques, Supervision, Hadoop, Hive, Kafka, Delta Lake, Elasticsearch, IaC, Internship, Kubernetes, MLflow, Prometheus, Streaming, TFX

Descriptif du stage La donnée est un actif précieux des entreprises. Le data engineer collecte, convertit et valorise la donnée brute en une information exploitable par les business analysts et les…

Par WORMS David

25 oct. 2021

Stage Web Technologies

Catégories : Front End, Formation | Tags : DevOps, LDAP, React.js, CI/CD, Docker, GraphQL, IaC, Internship, Kubernetes, Node.js, OAuth2

Descriptif du stage Dans le cadre de ses activités Big Data, Adaltas Academy est une plateforme de partage d’information regroupant des articles, des contenus de formation et une base de connaissance…

Par WORMS David

14 oct. 2021

Adaltas Summit 2021, seconde édition sur l'Île de Beauté

Catégories : Adaltas Summit 2021, Formation | Tags : Ansible, Hadoop, Spark, Azure, Blockchain, Deep Learning, Docker, Terraform, Kubernetes, Node.js

Pour sa seconde édition, l’ensemble de l’équipe Adaltas se réunit en Corse pour une semaine avec 2 jours dédiés à parler tech les 23 et 24 septembre 2021. Après une année et demi de restriction…

Par WORMS David

21 sept. 2021

Exécution des build Travis CI en local avec Docker

Catégories : DevOps & SRE, Front End | Tags : Bash, Tools, CI/CD, Node.js, Tests unitaires

La configuration de l’environnement pour effectuer les tests sur un CI/CD peut nécessiter quelques allers-retours entre votre machine hôte et le CI/CD fonctionnant à distance. Pour chaque tentative…

Par WORMS David

6 sept. 2021

Désacraliser le overlay filesystem de Linux dans Docker

Catégories : Orchestration de conteneurs, Infrastructure | Tags : DevOps, Système de fichiers, Linux, Docker

Le overlay filesystem (également appelés union filesystems) est une technologie fondamentale dans Docker pour créer des images et des conteneurs. Ils permettent de créer une union de répertoires pour…

Par WORMS David

3 juin 2021

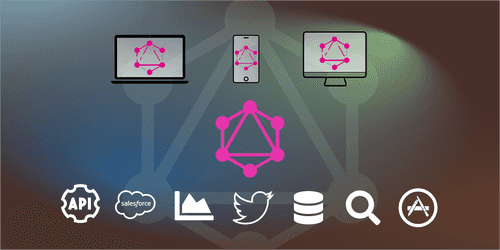

Parcourir DBnomics avec GraphQL et connecter son schéma OpenAPI

Catégories : DevOps & SRE, Front End | Tags : Data Engineering, JAMstack, GraphQL, JavaScript, Node.js, REST, Schéma

Aujourd’hui, dans le cadre de la rédaction d’un long et fastidieux document, il était mentionné DBnomics, une plateforme ouverte fédérant des ensembles de données économiques. En parcourant son site…

Par WORMS David

8 avr. 2021

JS monorepos en prod 4 : tests unitaires avec Mocha et Should.js

Catégories : DevOps & SRE, Front End | Tags : Automation, CI/CD, Git, GitOps, Monorepo, Node.js, Tests unitaires

Les tests unitaires sont cruciaux pour tous les projets à long terme et permettent d’isoler des fonctionnalités de votre code en unités testables. En effet, l’objectif principal des tests unitaires…

Par WORMS David

25 févr. 2021

JS monorepos en prod 3 : validation de commits et generation du changelog

Catégories : DevOps & SRE, Front End | Tags : CI/CD, Git, JavaScript, Monorepo, Node.js, Versions et évolutions, Tests unitaires

Conventional Commits introduit un format structuré pour les message de commit. Il standardise les messages entre tous les contributeurs. Cela les rend plus lisibles et plus faciles à automatiser. Il…

Par WORMS David

2 févr. 2021

JS monorepos en prod 2 : gestion des versions et de la publication

Catégories : DevOps & SRE, Front End | Tags : CI/CD, Git, GitOps, JavaScript, Monorepo, Node.js, Versions et évolutions, Tests unitaires

Un des grands avantages d’un monorepo est de maintenir des versions cohérentes entre les packages et d’automatiser la création des versions et la publication des packages. Cet article couvre les…

Par WORMS David

11 janv. 2021

JS monorepos en prod 1 : initialization du projet

Catégories : DevOps & SRE, Front End | Tags : Git, GitOps, JavaScript, Monorepo, Node.js, Versions et évolutions

Chaque projet commence par l’étape d’initialisation. Lorsque votre projet est composé de plusieurs sous-projets, il est tentant de créer un dépôt Git par sous-projet. Dans Node.js, un sous-projet se…

Par WORMS David

5 janv. 2021

OAuth2 et OpenID Connect pour les microservices et les applications publiques (Partie 2)

Catégories : Orchestration de conteneurs, Cybersécurité | Tags : LDAP, Micro Services, CNCF, JavaScript Object Notation (JSON), OAuth2, OpenID Connect

En utilisant OAuth2 et OpenID Connect, il est important de comprendre comment se déroule le flux d’autorisation, qui appelle l’Authorization Server et comment stocker les tokens. De plus, les…

Par WORMS David

20 nov. 2020

OAuth2 et OpenID Connect, une introduction douce et fonctionnelle (Part 1)

Catégories : Orchestration de conteneurs, Cybersécurité | Tags : Go Lang, JAMstack, LDAP, CNCF, Kubernetes, OAuth2, OpenID Connect

La compréhension d’OAuth2, d’OpenID et d’OpenID Connect (OIDC), comment ils sont liés, comment les communications sont établies, comment s’architecture votre application et que faire des différents…

Par WORMS David

17 nov. 2020

Architecture de plugins en JavaScript et Node.js avec Plug and Play

Catégories : Front End, Node.js | Tags : Asynchrone, DevOps, Programmation, Agile, JavaScript, Open source, Versions et évolutions

Plug and Play aide les auteurs de bibliothèques et d’applications à introduire une architecture de plugins dans leur code. Il simplifie l’exécution de code complexe avec des points d’interception bien…

Par WORMS David

28 août 2020

Cloudera CDP et migration Cloud de votre Data Warehouse

Catégories : Big Data, Cloud computing | Tags : Azure, Cloudera, Data Hub, Data Lake, Entrepôt de données (Data Warehouse)

Alors que l’un de nos clients anticipe un passage vers le Cloud et avec l’annonce récente de la disponibilité de Cloudera CDP mi-septembre lors de la conférence Strata, il semble que le moment soit…

Par WORMS David

16 déc. 2019

Stage Data Science & Data Engineer - ML en production et ingestion streaming

Catégories : Data Engineering, Data Science | Tags : DevOps, Flink, Hadoop, HBase, Kafka, Spark, Internship, Kubernetes, Python

Contexte L’évolution exponentielle des données a bouleversé l’industrie en redéfinissant les méthodes de stockages, de traitement et d’acheminement des données. Maitriser ces méthodes facilite…

Par WORMS David

26 nov. 2019

Stage InfraOps & DevOps - construction d'une offre PaaS Big Data & Kubernetes

Catégories : Big Data, Orchestration de conteneurs | Tags : DevOps, LXD, Hadoop, Kafka, Spark, Ceph, Internship, Kubernetes, NoSQL

Contexte L’acquisition d’un cluster à forte capacité répond à la volonté d’Adaltas de construire une offre de type PAAS pour disposer et mettre à disposition des plateformes de Big Data et d…

Par WORMS David

26 nov. 2019

Authentification Kerberos et Spnego sur Windows avec Firefox

Catégories : Cybersécurité | Tags : Firefox, HTTP, FreeIPA, Kerberos

Dans la mythologie grecque, Kerberos, aussi appelé Cerbère, garde les portes du monde souterrain pour empêcher les morts de partir. Il est communément décrit comme un chien à trois têtes ayant une…

Par WORMS David

4 nov. 2019

Notes sur le nouveau modèle de licences Open Source de Cloudera

Catégories : Big Data | Tags : CDSW, Licence, Cloudera Manager, Open source

Suite à la publication de sa stratégie de licences Open Source le 10 juillet 2019 dans un article intitulé “notre engagement envers les logiciels Open Source”, Cloudera a diffusé un webinaire hier le…

Par WORMS David

25 oct. 2019

Innovation, culture projet vs culture produit en Data Science

Catégories : Data Science, Gouvernance des données | Tags : DevOps, Agile, Scrum

La Data Science porte en elle le métier de demain. Elle est étroitement liée à la compréhension du métier, des comportements et de l’intelligence qu’on tirera des données existantes. Les enjeux sont à…

Par WORMS David

8 oct. 2019

Gatbsy.js, React et GraphQL pour nos documentations

Catégories : Adaltas Summit 2018, Front End | Tags : Gatsby, HTTP, JAMstack, React.js, SEO, API, GitOps, GraphQL, JavaScript, Markdown, Node.js

Au cours des derniers mois, j’ai consacrer un peu de temps à la ré-écritures de quelques sites Web pour nos projets Open Source. Ces sites incluent le projet CSV de Node.js, le client HBase pour Node…

Par WORMS David

1 avr. 2019

Les principaux avantages de GraphQL comme alternative au REST

Catégories : Front End | Tags : gRPC, API, GraphQL, JavaScript Object Notation (JSON), Node.js, Registre, REST

GraphQL est basé sur une idée simple, déplacer l’assemblage d’une requête du serveur vers le client. Ce dernier voit l’ensemble du schéma fortement typé au lieu d’une multitude de services REST et…

Par WORMS David

27 nov. 2018

Node.js CSV version 4 - réécriture et performances

Catégories : Node.js | Tags : CLI, Data Engineering, Refactoring, CSV, Versions et évolutions

Nous publions aujourd’hui une nouvelle version majeure du projet CSV Parser pour Node.js. La version 4 est une réécriture complète du projet axée sur la performance. Il comporte également de nouvelles…

Par WORMS David

19 nov. 2018

Gestion des identités utilisateurs sur clusters Big Data

Catégories : Cybersécurité, Gouvernance des données | Tags : LDAP, Active Directory, Ansible, FreeIPA, IAM, Kerberos

La sécurisation d’un cluster Big Data implique l’intégration ou le déploiement de services spécifiques pour stocker les utilisateurs. Certains utilisateurs sont spécifiques à un cluster lorsque d…

Par WORMS David

8 nov. 2018

Une semaine à discuter techno isolés dans un riad Marocain

Catégories : Adaltas Summit 2018, Formation | Tags : CDSW, Gatsby, React.js, Flink, Hadoop, Knox, Data Science, Deep Learning, Kubernetes, Node.js

Adaltas organise sa première conférence entre les 22 et 26 Octobre. Au programme de ces 5 jours de conférence : discuter de technologie dans l’un des plus beau riad de Marrakech. Mélanger l’utile à l…

Par WORMS David

11 oct. 2018

Déploiement d'un cluster Flink sécurisé sur Kubernetes

Catégories : Big Data | Tags : Chiffrement, Flink, HDFS, Kafka, Elasticsearch, Kerberos, SSL/TLS

Le déploiement sécurisée d’une application Flink dans Kubernetes, entraine deux options. En supposant que votre Kubernetes est sécurisé, vous pouvez compter sur la plateforme sous-jacente ou utiliser…

Par WORMS David

8 oct. 2018

Ingestion de Data Lake, quelques bonnes pratiques

Catégories : Big Data, Data Engineering | Tags : Gouvernance des données, HDF, Exploitation, Avro, Hive, NiFi, ORC, Spark, Data Lake, Format de fichier, Protocol Buffers, Registre, Schéma

La création d’un Data Lake demande de la rigueur et de l’expérience. Voici plusieurs bonnes pratiques autour de l’ingestion des données en batch et en flux continu que nous recommandons et mettons en…

Par WORMS David

18 juin 2018

Questions essentielles sur les base de données Time Series

Catégories : Big Data | Tags : Druid, HBase, Hive, ORC, Data Science, Elasticsearch, Grafana, IOT

Aujourd’hui, le gros des données Big Data est de nature temporelle. On le constate dans les médias comme chez nos clients : compteurs intelligents, transactions bancaires, usines intelligentes,…

Par WORMS David

18 mars 2018

Notes sur Katacoda relatives à l'orchestrateur de conteneur Kubernetes

Catégories : Orchestration de conteneurs, Formation | Tags : Helm, Kubeadm, CNI, Micro Services, Minikube, Ingress, Kubernetes

Il y a quelques semaines, j’ai consacré deux jours pour suivre les cours relatifs à la solution d’orchestration de *container Kubernetes mis à disposition sur la plateforme Katacoda. Je partage ces…

Par WORMS David

14 déc. 2017

Micro Services

Catégories : Cloud computing, Orchestration de conteneurs, Open Source Summit Europe 2017 | Tags : Mesos, DNS, Chiffrement, gRPC, Linkerd, Micro Services, MITM, Service Mesh, CNCF, Istio, Kubernetes, Proxy, SPOF, SSL/TLS

Historiquement, les applications étaient monolithiques et nous pouvions utiliser une adresse IP pour accéder à un service. Avec les machines virtuelles (VM), plusieurs hôtes commencent à apparaître…

Par WORMS David

14 nov. 2017

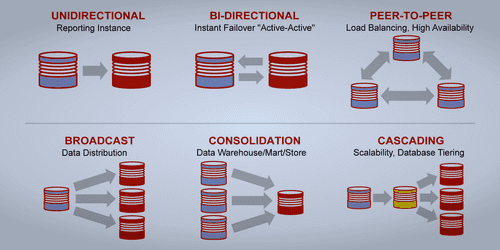

MariaDB integration with Hadoop

Catégories : Infrastructure | Tags : Base de données, HA, MariaDB, Hadoop, Hive

Lors d’ateliers menés avec l’un de nos clients, Adaltas a levé un risque potentiel sur la stratégie utilisée pour la mise en haute disponibilité (HA) de MariaDB. Le client ayant sélectionné la…

Par WORMS David

31 juil. 2017

Synchronisation Oracle vers Hadoop avec un CDC

Catégories : Data Engineering | Tags : CDC, GoldenGate, Oracle, Hive, Sqoop, Entrepôt de données (Data Warehouse)

Cette note résulte d’une discussion autour de la synchronisation de données écrites dans une base de données à destination d’un entrepôt stocké dans Hadoop. Merci à Claude Daub de GFI qui la rédigea…

Par WORMS David

13 juil. 2017

Hive Metastore HA avec DBTokenStore : Failed to initialize master key

Catégories : Big Data, DevOps & SRE | Tags : Infrastructure, Hive, Bug

Cet article décrit ma petite aventure autour d’une erreur au démarrage du Hive Metastore. Elle se reproduit dans un environnement précis qui est celui d’une installation sécurisée, entendre avec…

Par WORMS David

21 juil. 2016

EclairJS - Un peu de Spark dans les Web Apps

Catégories : Data Engineering, Front End | Tags : Spark, JavaScript, Jupyter

Présentation de David Fallside, IBM. Les images sont issues des slides de présentation. Introduction Le développement d’applications Web est passé d’un environnement Java vers des environnements…

Par WORMS David

17 juil. 2016

Hive, Calcite et Druid

Catégories : Big Data | Tags : Druid, Business Intelligence, Base de données, Hadoop, Hive

BI/OLAP est nécessaire à la visualisation interactive de flux de données : Évènements issus d’enchères en temps réel Flux d’activité utilisateur Log de téléphonie Suivi du trafic réseau Évènements de…

Par WORMS David

14 juil. 2016

L'offre Red Hat Storage et son intégration avec Hadoop

Catégories : Big Data | Tags : GlusterFS, Red Hat, Hadoop, HDFS, Storage

J’ai eu l’occasion d’être introduit à Red Hat Storage et Gluster lors d’une présentation menée conjointement par Red Hat France et la société StartX. J’ai ici recompilé mes notes, du moins…

Par WORMS David

3 juil. 2015

Un middleware pour connect simple pour transpiler des fichiers CoffeeScript

Catégories : Hack, Node.js | Tags : Tools, CoffeeScript, Node.js

Ce nouveau module appelé connect-coffee-script est un middleware Connect utilisé pour servir les fichiers JavaScript écrits en CoffeeScript. Ce middleware doit être utilisé par connect ou tout…

Par WORMS David

4 juil. 2014

Diviser des fichiers HDFS en plusieurs tables Hive

Catégories : Data Engineering | Tags : Flume, Pig, HDFS, Hive, Oozie, SQL

Je vais montrer comment scinder fichier CSV stocké dans HDFS en plusieurs tables Hive en fonction du contenu de chaque enregistrement. Le contexte est simple. Nous utilisons Flume pour collecter les…

Par WORMS David

15 sept. 2013

E-commerce cigarettes électroniques : impressions sur Prestashop

Catégories : Tech Radar | Tags : HTML, Java, Node.js

L’année dernière, il m’a fallu choisir et intégrer une solution e-commerce pour le site de vente de cigarettes électroniques CigarHit. Etant donné que ma dernière intégration d’un site e-commerce…

Par WORMS David

25 juil. 2012

Node CSV version 0.2.1

Catégories : Node.js | Tags : CoffeeScript, CSV, Versions et évolutions, Streaming

Faisant suite à l’annonce de la version 0.2.0 du parser CSV pour Node.js début octobre, aujourd’hui sort la nouvelle version 0.2.1. Il s’agit essentiellement d’une distribution corrigeant des bugs…

Par WORMS David

24 juil. 2012

Traverser des arrays en mode asynchronisé dans Node.js avec Each

Catégories : Node.js | Tags : Asynchrone, CoffeeScript, JavaScript, Versions et évolutions

Les librairies en Node.js permettant de gérer et simplifier les appels asynchrones sont légions. Voici le genre de librairies que chacun écrit pour lui et éventuellement publie. Elles ont pour but de…

Par WORMS David

18 juil. 2012

Installation de PostgreSQL et Madlib sur OSX

Catégories : Data Science | Tags : Base de données, Greenplum, Statistiques, PostgreSQL, SQL

Nous couvrons l’installation et l’utilisation de PostgreSQL et de MADlib sur OSX et Ubuntu. Les instructions pour les autres environnements doivent être similaires. PostgreSQL est une base de données…

Par WORMS David

7 juil. 2012

Notes sur le rapport Gallois par une entreprise informatique

Catégories : Tech Radar | Tags : Gouvernance des données, Loi, Big Data

Dans le cadre de la lecture du rapport Gallois rendu publique hier, j’ai conservé quelques notes qui après recompilation sont publiées en ligne. On peut certes regretter le manque de mention sur le…

Par WORMS David

6 juil. 2012

Node CSV version 0.2 incluant le support de l'API streaming

Catégories : Node.js | Tags : CSV, Markdown, Node.js, Streaming

Annoncé en Août, le parser CSV pour Node.js dans sa version 0.2 est sorti hier. Cette version est une mise à jour majeure dans le sens ou elle aligne l’API de la librairie avec les meilleures…

Par WORMS David

2 juil. 2012

Stockage HDFS et Hive - comparaison des formats de fichiers et compressions

Catégories : Data Engineering | Tags : Business Intelligence, Hive, ORC, Parquet, Format de fichier

Il y a quelques jours, nous avons conduit un test dans le but de comparer différents format de fichiers et méthodes de compression disponibles dans Hive. Parmi ces formats, certains sont natifs à HDFS…

Par WORMS David

13 mars 2012

Deux Hive UDAF pour convertir une aggregation vers une map

Catégories : Data Engineering | Tags : Java, HBase, Hive, Format de fichier

Je publie deux nouvelles fonctions UDAF pour Hive pour aider avec les map dans Apache Hive. Le code source est disponible sur GitHub dans deux classes Java : “UDAFToMap” et “UDAFToOrderedMap” ou vous…

Par WORMS David

6 mars 2012

Java versus JS, citation de la mailing list de Node.js

Catégories : Node.js | Tags : Java, JavaScript, Node.js

Je viens de lire celui-ci sur la mailing list de Node.js. J’ai trouv�é l’échange pertinent, suffisamment pour le partager avec ceux qui n’auraient pas souscrit a la mailing list : Tout d’abord Lothar…

Par WORMS David

23 févr. 2012

Un regard neuf sur les tests de projets Node.js : Mocha, Should et Travis

Catégories : DevOps & SRE, Node.js | Tags : DevOps, Mocha, JavaScript, Node.js, Tests unitaires

Suite à une demande, l’article ci-dessous est la traduction d’un précédent publié le 19 février 2012. Aujourd’hui, j’ai finalement décidé de passer un peu de temps autour de Travis. Cette petite image…

Par WORMS David

19 févr. 2012

Coffee script, comment mettre la main sur cette ligne ?

Catégories : Hack, Node.js | Tags : Debug, CoffeeScript, JavaScript, Node.js

Mise à jour du 12 avril 2012 : Pull Request ajoutant un un mappage aux rapports d’erreur CoffeeScript Il est probable que, si vous codez en CoffeeScript, vous vous retrouvez souvent face à une…

Par WORMS David

15 févr. 2012

Lancement de Mecano, fonctions pour le déploiement de systèmes

Catégories : DevOps & SRE, Node.js | Tags : Automation, Infrastructure, CoffeeScript, JavaScript, Open source

Mis à jour en juillet 2016, Mecano est désormais renommé Nikita. Nous publions Node Mecano sur GitHub, qui regroupent des fonctions communes utilisées lors du déploiement de systèmes. L’idée était de…

Par WORMS David

12 févr. 2012

Node CSV parser à la rescousse

Catégories : Hack | Tags : Bash, Hack, CSV, Node.js

Vendredi dernier, une heure avant la fermeture des portes de mon client pour le week-end, un collègue est venu me voir. Il vient juste de finir d’exporter 9 fichiers CSV à partir d’une base de données…

Par WORMS David

13 déc. 2011

Node.js intégré à la plateforme cloud Microsoft Azure

Catégories : Cloud computing, Tech Radar | Tags : Linux, Azure, Cloud, Node.js

Node est désormais un citoyen de premier ordre dans l’environnement cloud de Microsoft Azure au côté de .Net, Java et PHP. Cette intégration est la conséquence logique de l’implication de Microsoft…

Par WORMS David

11 déc. 2011

Chef : configuration et deploiement automatisé de Clusters

Catégories : DevOps & SRE, Infrastructure | Tags : Automation, Chef, Enseignement et tutorial, Puppet, Hadoop, Déploiement

L’installation d’un cluster de plusieurs machines est consommateur de temps. La même procédure de mise en place des logiciels et de leurs paramétrages doit être répétée à l’identique. Au cours du…

Par WORMS David

10 déc. 2010

Installation d'Hadoop et d'HBase sous OSX en mode pseudo-distribué

Catégories : Big Data, Formation | Tags : Hue, Infrastructure, Hadoop, HBase, Big Data, Déploiement

Le système d’exploitation choisi est OSX mais la procédure n’est pas si différente pour tout environnement Unix car l’essentiel des logiciels est téléchargé depuis Internet, décompressé et paramétré…

Par WORMS David

1 déc. 2010

Stockage et traitement massif avec Hadoop

Catégories : Big Data | Tags : Hadoop, HDFS, Storage

Apache Hadoop est un système pour construire des infrastructures de stockage partagé et d’analyses adaptées à des volumes larges (plusieurs terabytes ou petabytes). Les clusters Hadoop sont utilisés…

Par WORMS David

26 nov. 2010

Stockage et traitement massif avec Hadoop

Catégories : Big Data, Node.js | Tags : HBase, Big Data, Node.js, REST

HBase est la base de données de type “column familly” de l’écosystème Hadoop construite sur le modèle de Google BigTable. HBase peut accueillir de très larges volumes de données (de l’ordre du tera ou…

Par WORMS David

1 nov. 2010

Présentation de MapReduce

Catégories : Big Data | Tags : Java, MapReduce, Big Data, JavaScript

Les systèmes d’information ont de plus en plus de données à stocker et à traiter. Des entreprises comme Google, Facebook, Twitter mais encore bien d’autre stockent des quantités d’information…

Par WORMS David

26 juin 2010

Node.js, JavaScript côté serveur

Catégories : Front End, Node.js | Tags : HTTP, Serveur, JavaScript, Node.js

En attente du prochain grand language (NBL pour Next Big Language), cela fait maintenant 3 ans que je prédis à mes clients un bel avenir au JavaScript comme langue de programmation pour les…

Par WORMS David

12 juin 2010