Tous nos articles

Keyser, unique script bash pour la gestion de certificats SSL

Catégories : Cybersécurité, DevOps & SRE | Tags : Bash, Cybersécurité, DevOps, Chiffrement, SSL/TLS

Keyser est un utilitaire en ligne de commande conçu pour simplifier la création, la gestion et la protection des certificats SSL de manière efficace et sécurisée. Distribué sous la forme d’un script…

Par MORCILLO Eliott

25 juin 2025

Export de Buttercup vers KeePass

Catégories : Cybersécurité | Tags : Authentification, CSV, Node.js

Buttercup est un gestionnaire de mots de passe qui fonctionne sur les systèmes Linux, macOS, Windows, iOS et Android. Le 3 mars, le principal contributeur de Buttercup, Perry Mitchell, a annoncé…

Par WORMS David

14 mai 2025

Utilisation des attributs Git

Catégories : DevOps & SRE | Tags : Git, GitOps

Les attributs Git ne sont pas un concept que l’on apprend dans les premiers temps lorsqu’on se familiarise avec Git. Même les développeurs expérimentés ne les connaissent pas toujours en raison de…

Par KUDINOV Sergei

25 janv. 2025

Méthodes pour le suivit de connection SSH

Catégories : DevOps & SRE | Tags : Bash, DevOps

Pour des besoins d’enseigmement chez Adaltas, nous fournissons des conteneurs isolés à nos étudiants. Les étudiants disposent d’une connexion SSH commune et sont redirigés vers un conteneur dédié…

Par WORMS David

11 nov. 2024

Introduction à OpenLineage

Catégories : Big Data, Gouvernance des données, Infrastructure | Tags : Data Engineering, Infrastructure, Atlas, Data Lake, Lakehouse, Entrepôt de données (Data Warehouse), Traçabilité (data lineage)

OpenLineage est une spécification open source de lineage des données. La spécification est complétée par Marquez, son implémentation de référence. Depuis son lancement fin 2020, OpenLineage est…

19 févr. 2024

Guide d'installation à TDP, la plateforme big data 100% open source

Catégories : Big Data, Infrastructure | Tags : Infrastructure, VirtualBox, Hadoop, Vagrant, TDP

La Trunk Data Platforme (TDP) est une distribution big data 100% open source, basée sur Apache Hadoop et compatible avec HDP 3.1. Initiée en 2021 par EDF, la DGFiP et Adaltas, le projet est gouverné…

Par FARAULT Paul

18 oct. 2023

Lancement du site Internet de TDP

Catégories : Big Data | Tags : Programmation, Ansible, Hadoop, Python, TDP

Le nouveau site Internet de TDP (Trunk Data Platform) est en ligne. Nous vous invitons à le parcourir pour découvrir la platorme, rester informés, et cultiver le contact avec la communauté TDP. TDP…

Par WORMS David

3 oct. 2023

CDP partie 6 : cas d'usage bout en bout d'un Data Lakehouse avec CDP

Catégories : Big Data, Data Engineering, Formation | Tags : Business Intelligence, Data Engineering, Iceberg, NiFi, Spark, Big Data, Cloudera, CDP, Analyse de données, Data Lake, Entrepôt de données (Data Warehouse)

Dans cet exercice pratique, nous montrons comment construire une solution big data complète avec la Cloudera Data Platform (CDP) Public Cloud, en se basant sur l’infrastructure qui a été déployée tout…

Par CHAVARRIA Tobias

24 juil. 2023

CDP partie 5 : gestion des permissions utilisateurs sur CDP

Catégories : Big Data, Cloud computing, Gouvernance des données | Tags : Ranger, Cloudera, CDP, Entrepôt de données (Data Warehouse)

Lorsqu’un utilisateur ou un groupe est créé dans CDP, des permissions doivent leur être attribuées pour accéder aux ressources et utiliser les Data Services. Cet article est le cinquième d’une série…

Par CHAVARRIA Tobias

18 juil. 2023

CDP partie 4 : gestion des utilisateurs sur CDP avec Keycloak

Catégories : Big Data, Cloud computing, Gouvernance des données | Tags : EC2, Big Data, CDP, Docker Compose, Keycloak, SSO

Les articles précédents de la série couvrent le déploiement d’un environnement CDP Public Cloud. Tous les composants sont prêts à être utilisés et il est temps de mettre l’environnement à la…

Par CHAVARRIA Tobias

4 juil. 2023

CDP partie 3 : activation des Data Services en environnment CDP Public Cloud

Catégories : Big Data, Cloud computing, Infrastructure | Tags : Infrastructure, AWS, Big Data, Cloudera, CDP

L’un des principaux arguments de vente de Cloudera Data Platform (CDP) est la maturité de son offre de services. Ceux-ci sont faciles à déployer sur site, dans le cloud public ou dans le cadre d’une…

Par KONRAD Albert

27 juin 2023

CDP partie 2 : déploiement d'un environnement CDP Public Cloud sur AWS

Catégories : Big Data, Cloud computing, Infrastructure | Tags : Infrastructure, AWS, Big Data, Cloud, Cloudera, CDP, Cloudera Manager

La Cloudera Data Platform (CDP) Public Cloud constitue la base sur laquelle des lacs de données (Data Lake) complets sont créés. Dans un article précédent, nous avons présenté la plateforme CDP. Cet…

Par KONRAD Albert

19 juin 2023

CDP partie 1 : introduction à l'architecture Data Lakehouse avec CDP

Catégories : Cloud computing, Data Engineering, Infrastructure | Tags : Data Engineering, Iceberg, AWS, Azure, Big Data, Cloud, Cloudera, CDP, Cloudera Manager, Entrepôt de données (Data Warehouse)

Cloudera Data Platform (CDP) est une data platform hybride pour l’intégration de donnée, le machine learning et l’analyse de la data. Dans cette série d’articles nous allons décrire comment installer…

Par BAUM Stephan

8 juin 2023

Des environnements de développement locaux avec Terraform + LXD

Catégories : Orchestration de conteneurs, DevOps & SRE | Tags : Automation, DevOps, KVM, LXD, Virtualisation, VM, Terraform, Vagrant

En tant qu’architecte de solutions Big Data et InfraOps, j’ai besoin d’environnements de développement pour installer et tester des logiciels. Ils doivent être configurables, flexibles et performants…

Par LEONARD Gauthier

1 juin 2023

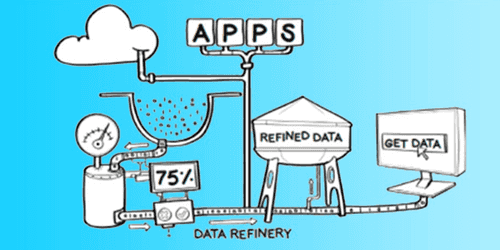

Exigences et attentes d'une plateforme Big Data

Catégories : Big Data, Infrastructure | Tags : Data Engineering, Gouvernance des données, Analyse de données, Data Hub, Data Lake, Lakehouse, Data Science

Une plateforme Big Data est un système complexe et sophistiqué qui permet aux organisations de stocker, traiter et analyser de gros volumes de données provenant de diverses sources. Elle se compose de…

Par WORMS David

23 mars 2023

Déploiement de Keycloak sur EC2

Catégories : Cloud computing, Data Engineering, Infrastructure | Tags : EC2, sécurité, Authentification, AWS, Docker, Keycloak, SSL/TLS, SSO

Pourquoi utiliser Keycloak Keycloak est un fournisseur d’identité open source (IdP) utilisant l’authentification unique SSO. Un IdP est un outil permettant de créer, de maintenir et de gérer les…

Par BAUM Stephan

14 mars 2023

Gestion de Kafka dans Kubernetes avec Strimzi

Catégories : Big Data, Orchestration de conteneurs, Infrastructure | Tags : Kafka, Big Data, Kubernetes, Open source, Streaming

Kubernetes n’est pas la première plateforme à laquelle on pense pour faire tourner des clusters Apache Kafka. En effet, la forte adhérence de Kafka au stockage pourrait être difficile à gérer par…

Par SCHOUKROUN Leo

7 mars 2023

Kubernetes : déboguer avec les conteneurs éphémères

Catégories : Orchestration de conteneurs, Tech Radar | Tags : Debug, Kubernetes

Tout individu ayant eu un jour à manipuler Kubernetes s’est retrouvé confronter à la résolution d’erreurs de pods. Les méthodes prévues à cet effet sont performantes, et permettent de venir à bout des…

Par BERLAND Pierre

7 févr. 2023

Plongée dans tdp-lib, le SDK en charge de la gestion de clusters TDP

Catégories : Big Data, Infrastructure | Tags : Programmation, Ansible, Hadoop, Python, TDP

Tous les déploiements TDP sont automatisés. Ansible y joue un rôle central. Avec la complexité grandissante de notre base logicielle, un nouveau système était nécessaire afin de s’affranchir des…

Par BOUTRY Guillaume

24 janv. 2023

Adaltas Summit 2022 Morzine

Catégories : Big Data, Adaltas Summit 2022 | Tags : Data Engineering, Infrastructure, Iceberg, Conteneur, Lakehouse, Docker, Kubernetes

Pour sa troisième édition, toute l’équipe d’Adaltas se retrouve à Morzine pour une semaine entière avec 2 jours dédiés à la technologie les 15 et 16 septembre 2022. Les intervenants choisissent l’un…

Par WORMS David

13 janv. 2023

Comment construire ses images OCI avec Buildpacks

Catégories : Orchestration de conteneurs, DevOps & SRE | Tags : CI/CD, CNCF, Docker, Kubernetes, OCI

Docker est désormais devenu un standard pour déployer son application. Dans une image Docker on place notre code source, ses dépendances, quelques configurations et notre application est quasiment…

9 janv. 2023

Stage infrastructure big data

Catégories : Big Data, Data Engineering, DevOps & SRE, Infrastructure | Tags : Infrastructure, Hadoop, Big Data, Cluster, Internship, Kubernetes, TDP

Présentation de l’offre Le Big Data et l’informatique distribuée sont au cœur d’Adaltas. Nous accompagnons nos partenaires dans le déploiement, la maintenance, l’optimisation et nouvellement le…

Par BAUM Stephan

2 déc. 2022

Traefik, Docker et dnsmasq pour simplifier la mise en réseau des conteneurs

Catégories : Orchestration de conteneurs, Infrastructure, Tech Radar | Tags : DNS, Gatsby, JAMstack, Linux, Docker, Réseau

Les bonnes aventures technologiques commencent par une certaine frustration, un besoin ou une exigence. C’est l’histoire de la façon dont j’ai simplifié la gestion et l’accès de mes applications Web…

Par WORMS David

17 nov. 2022

WasmEdge : Les runtimes WebAssembly sont en routes pour l'edge computing

Catégories : Orchestration de conteneurs, Adaltas Summit 2021, Infrastructure, Tech Radar | Tags : JAMstack, Linux, Docker, Rust Lang, WebAssembly

Avec de nombreux de nombreux défis en matière de sécurité résolus de par sa conception, beaucoup de projets bénéficient de l’utilisation du WebAssembly. Le runtime WasmEdge est une machine virtuelle…

Par BOUTRY Guillaume

29 sept. 2022

Ingress et Load Balancers dans Kubernetes avec MetalLB et nginx-ingress

Catégories : Orchestration de conteneurs, Infrastructure, Tech Radar | Tags : Kubeadm, Cluster, Déploiement, Ingress, Kubernetes

Lorsque l’on souhaite exposer des services depuis un cluster Kubernetes et les rendre accessibles depuis l’extérieur du cluster, la solution la plus adéquate est d’utiliser des services de type load…

Par COTTART Kellian

8 sept. 2022

Intégration de Spark et Hadoop dans Jupyter

Catégories : Adaltas Summit 2021, Infrastructure, Tech Radar | Tags : Infrastructure, Spark, YARN, CDP, HDP, Jupyter, Notebook, TDP

Depuis quelques années, Jupyter notebook s’impose comme la principale solution de notebook dans l’univers Python. Historiquement, Jupyter est l’outil de prédilection des data scientists développant…

Par COINTEPAS Aargan

1 sept. 2022

Ordinateur portable Framework avec NixOS, un retour d'expérience

Catégories : Formation, Tech Radar | Tags : CLI, DevOps, Enseignement et tutorial, Linux, Packaging, NixOS, Open source

Un nouveau travail commence avec un nouvel ordinateur portable. À ce titre, on m’a donné un Framework Laptop DIY Edition avec pour mission de l’installer et de le configurer entièrement avec NixOS. Je…

22 août 2022

Stockage objet Ceph dans un cluster Kubernetes avec Rook

Catégories : Big Data, Gouvernance des données, Formation | Tags : Amazon S3, Big Data, Ceph, Cluster, Data Lake, Kubernetes, Storage

Ceph est un système tout-en-un de stockage distribué. Fiable et mature, sa première version stable est parue en 2012 et a été depuis la référence pour le stockage open source. L’avantage principal de…

Par BIGOT Luka

4 août 2022

Stockage objet avec MinIO dans un cluster Kubernetes

Catégories : Big Data, Gouvernance des données, Formation | Tags : Amazon S3, Big Data, Cluster, Data Lake, Kubernetes, Storage

MinIO est une solution de stockage objet populaire. Souvent recommandé pour sa simplicité d’utilisation et d’installation, MinIO n’est pas seulement qu’un bon moyen pour débuter avec le stockage objet…

Par BIGOT Luka

9 juil. 2022

Architecture du stockage objet et attributs du standard S3

Catégories : Big Data, Gouvernance des données | Tags : Base de données, API, Amazon S3, Big Data, Data Lake, Storage

Le stockage objet a gagné en popularité parmi les architectures de stockage de données. Comparé aux systèmes de fichiers et au stockage bloc, le stockage objet ne rencontre pas de limitations lorsqu…

Par BIGOT Luka

20 juin 2022

TDP Workshop : devenir un power-user de TDP depuis son terminal

Catégories : Évènements, Formation | Tags : DevOps, Ansible, Hadoop, Open source, TDP

La CLI de TDP est utilisée pour déployer et exploiter vos services TDP. Elle s’appuie sur tdp-lib pour vous offrir contrôle et flexibilité. Il y a quelques temps, nous annoncions la sortie publique de…

Par FARAULT Paul

17 juin 2022

Comparaison des architectures de base de données : data warehouse, data lake and data lakehouse

Catégories : Big Data, Data Engineering | Tags : Gouvernance des données, Infrastructure, Iceberg, Parquet, Spark, Data Lake, Lakehouse, Entrepôt de données (Data Warehouse), Format de fichier

Les architectures de base de données ont fait l’objet d’une innovation constante, évoluant avec l’apparition de nouveaux cas d’utilisation, de contraintes techniques et d’exigences. Parmi les trois…

17 mai 2022

NixOS : Activer le support des machines virtuelles de LXD avec Flakes

Catégories : Hack, Formation | Tags : GitHub, Enseignement et tutorial, Linux, LXD, Packaging, VM, NixOS, Open source

Nixpkgs est une collection grandissante de packages pour Nix et NixOS. Même avec plus de 80,000 packages, il est pourtant commun d’avoir besoin d’une fonctionnalité qui n’existe pas encore. Cette…

Par COTTART Kellian

13 mai 2022

Collecte de logs Databricks vers Azure Monitor à l'échelle d'un workspace

Catégories : Cloud computing, Data Engineering, Adaltas Summit 2021 | Tags : Métriques, Supervision, Spark, Azure, Databricks, Log4j

Databricks est une plateforme optimisée d’analyse de données, basée sur Apache Spark. La surveillance de la plateforme Databricks est cruciale pour garantir la qualité des données, les performances du…

Par PLAYE Claire

10 mai 2022

Découvrez Trunk Data Platform : La Distribution Big Data Open-Source par TOSIT

Catégories : Big Data, DevOps & SRE, Infrastructure | Tags : Ranger, DevOps, Hortonworks, Ansible, Hadoop, HBase, Knox, Spark, Cloudera, CDP, CDH, Open source, TDP

Depuis la fusion de Cloudera et Hortonworks, la sélection de distributions Hadoop commerciales on-prem se réduit à CDP Private Cloud. CDP est un mélange de CDH et de HDP conservant les meilleurs…

Par SCHOUKROUN Leo

14 avr. 2022

La blockchain pour les nuls 2 : Crypto-monnaies, portefeuilles et DApps

Catégories : Adaltas Summit 2021, Infrastructure | Tags : Cryptographie, Infrastructure, Blockchain, Consensus

Beaucoup de gens possèdent des crypto-monnaies aujourd’hui. Mais détenir quelques tokens sur un échange ne signifie pas interagir avec la blockchain. Les actifs que vous tradez ne sont que des nombres…

Par LEONARD Gauthier

12 avr. 2022

Monorepos JS en prod 7 : Intégration continue et déploiement continu avec GitHub Actions

Catégories : DevOps & SRE, Front End | Tags : CI/CD, Monorepo, Node.js, Tests unitaires

La valeur d’une CI/CD réside dans sa capacité à contrôler et à coordonner les changements et l’ajout de fonctionnalités dans plusieurs versions itératives tout en ayant simultanément plusieurs…

6 avr. 2022

Création de package Nix : installation d'une police non disponible

Catégories : Hack | Tags : Enseignement et tutorial, Linux, Packaging, GitOps, NixOS, Open source

La collection de packages Nix est importante avec plus de 60 000 packages. Cependant, il y a de fortes chances que parfois le package dont vous avez besoin ne soit pas disponible. Vous devez…

Par WORMS David

29 mars 2022

Deployez vos aplications IA conteneurisées avec nvidia-docker

Catégories : Orchestration de conteneurs, Data Science | Tags : containerd, DevOps, Enseignement et tutorial, NVIDIA, Docker, Keras, TensorFlow

De plus en plus de produits et services prennent avantage des capacités de modélisation et prédiction des IA. Cet article présente l’outil nvidia-docker permettant d’intégrer des briques logiciels IA…

24 mars 2022

Variables Ansible : choisir l'emplacement approprié

Catégories : DevOps & SRE | Tags : Infrastructure, Ansible, IaC, YAML

Définir des variables pour vos playbooks et rôles Ansible peut devenir un défi à mesure que votre projet se développe. Naviguer la documentation Ansible est source de questionnements et de confusion…

Par HERMAND Xavier

15 mars 2022

Apache HBase : colocation de RegionServers

Catégories : Big Data, Adaltas Summit 2021, Infrastructure | Tags : Ambari, Base de données, Infrastructure, Performance, Hadoop, HBase, Big Data, HDP, Storage

Les RegionServers sont les processus gérant le stockage et la récupération des données dans Apache HBase, la base de données non-relationnelle orientée colonne de Apache Hadoop. C’est à travers leurs…

Par BERLAND Pierre

22 févr. 2022

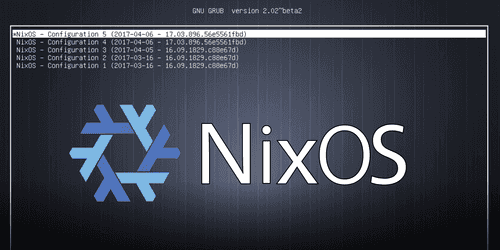

Installation fiable et reproductible de Linux avec NixOS

Catégories : Infrastructure, Formation | Tags : Linux, Packaging, VM, NixOS, TDP

Lors de l’utilisation d’un système d’exploitation, la mise à jour ou l’installation de packages sont des opérations courantes qui présentent un risque pour la stabilité du système. NixOS est une…

Par MOUAFFO Florent

8 févr. 2022

Introduction à Nix, concepts fondateurs et principales commandes

Catégories : Infrastructure, Formation | Tags : Arch Linux, CentOS, Linux, OS X, Packaging, Ubuntu, NixOS, TDP

Nix est un gestionnaire de packages fonctionnel pour Linux et d’autres systèmes Unix, rendant la gestion des packages plus fiable et reproductible. Avec un gestionnaire de packages traditionnel, lors…

Par MOUAFFO Florent

1 févr. 2022

La blockchain pour les nuls 1 : blockchains et mécanismes de consensus

Catégories : Adaltas Summit 2021, Infrastructure, Formation | Tags : Cryptographie, Infrastructure, Blockchain, Consensus

Les crypto-monnaies sont en plein essor en 2021, avec une capitalisation boursière passant de 750 à plus de 3 000 milliards de dollars. Soyons honnêtes, cela est principalement dû à la spéculation…

Par LEONARD Gauthier

18 janv. 2022

GitOps en pratique, déploiement d'applications Kubernetes avec ArgoCD

Catégories : Orchestration de conteneurs, DevOps & SRE, Adaltas Summit 2021 | Tags : Argo CD, CI/CD, Git, GitOps, IaC, Kubernetes

GitOps est un ensemble de pratiques pour déployer des applications à l’aide de Git. Les définitions, les configurations et la connectivité des applications sont stockées dans un logiciel de contrôle…

16 déc. 2021

JS monorepos en prod 6 : CI/CD, intégration et déploiement continue avec Travis CI

Catégories : DevOps & SRE, Front End | Tags : CI/CD, Monorepo, Node.js, Tests unitaires

La mise en place d’une intégration continue (CI) et d’un déploiement continu (CD) sur un monorepo est assez complexe en raison de la diversité des responsabilités entre les développeurs et de la…

Par WORMS David

6 déc. 2021

Stage de fin d'étude printemps 2022 - construction d'un Data Lab

Catégories : Data Science, Formation | Tags : Spark, Argo CD, Elasticsearch, Internship, Keycloak, Kubernetes, MongoDB, OpenID Connect, PostgreSQL

Descriptif du stage Au cours des dernières années, nous avons développé la capacité d’utiliser les ordinateurs pour traiter une grande quantité de données. L’écosystème a évolué vers une offre étendue…

Par WORMS David

24 nov. 2021

Version 6 du package CSV pour Node.js

Catégories : Node.js | Tags : Data Engineering, Refactoring, CSV, Format de fichier, Versions et évolutions

La dernière version du package pour Node.js vient d’être publiée ainsi que celles de ses sous-projects. Voici les versions publiées : version , précédente version NPM version , précédente version…

Par WORMS David

15 nov. 2021

H2O en pratique : un protocole combinant AutoML et les approches de modélisation traditionnelles

Catégories : Data Science, Formation | Tags : Automation, Cloud, H2O, Machine Learning, MLOps, On-premises, Open source, Python, XGBoost

H20 est livré avec de nombreuses fonctionnalités. La deuxième partie de la s�érie H2O en pratique propose un protocole pour combiner la modélisation AutoML avec des approches de modélisation et d…

12 nov. 2021

Stage de fin d'étude printemps 2022 en Data Engineering

Catégories : Front End, Formation | Tags : Métriques, Supervision, Hadoop, Hive, Kafka, Delta Lake, Elasticsearch, IaC, Internship, Kubernetes, MLflow, Prometheus, Streaming, TFX

Descriptif du stage La donnée est un actif précieux des entreprises. Le data engineer collecte, convertit et valorise la donnée brute en une information exploitable par les business analysts et les…

Par WORMS David

25 oct. 2021

Stage en infrastructure Big Data avec TDP

Catégories : Infrastructure, Formation | Tags : Cybersécurité, DevOps, Java, Ansible, Hadoop, Internship, TDP

Le Big Data et l’informatique distribuée sont au cœur d’Adaltas. Nous accompagnons nos partenaires dans le déploiement, la maintenance et l’optimisation de certains des plus grands clusters de France…

Par HARTY Daniel

25 oct. 2021

Stage Web Technologies

Catégories : Front End, Formation | Tags : DevOps, LDAP, React.js, CI/CD, Docker, GraphQL, IaC, Internship, Kubernetes, Node.js, OAuth2

Descriptif du stage Dans le cadre de ses activités Big Data, Adaltas Academy est une plateforme de partage d’information regroupant des articles, des contenus de formation et une base de connaissance…

Par WORMS David

14 oct. 2021

H2O en pratique: retour d'expérience d'un Data Scientist

Catégories : Data Science, Formation | Tags : Automation, Cloud, H2O, Machine Learning, MLOps, On-premises, Open source, Python

Les plates-formes d’apprentissage automatique (AutoML) gagnent en popularité et deviennent un outil puissant à disposition des data scientists. Il y a quelques mois, j’ai présenté H2O, une plate-forme…

29 sept. 2021

Adaltas Summit 2021, seconde édition sur l'Île de Beauté

Catégories : Adaltas Summit 2021, Formation | Tags : Ansible, Hadoop, Spark, Azure, Blockchain, Deep Learning, Docker, Terraform, Kubernetes, Node.js

Pour sa seconde édition, l’ensemble de l’équipe Adaltas se réunit en Corse pour une semaine avec 2 jours dédiés à parler tech les 23 et 24 septembre 2021. Après une année et demi de restriction…

Par WORMS David

21 sept. 2021

Exécution des build Travis CI en local avec Docker

Catégories : DevOps & SRE, Front End | Tags : Bash, Tools, CI/CD, Node.js, Tests unitaires

La configuration de l’environnement pour effectuer les tests sur un CI/CD peut nécessiter quelques allers-retours entre votre machine hôte et le CI/CD fonctionnant à distance. Pour chaque tentative…

Par WORMS David

6 sept. 2021

Utilisation de Cloudera Deploy pour installer Cloudera Data Platform (CDP) Private Cloud

Catégories : Big Data, Cloud computing | Tags : Ansible, Cloudera, CDP, Cluster, Entrepôt de données (Data Warehouse), Vagrant, IaC

Suite à notre récente présentation de CDP, passons désormais au déploiement CDP private Cloud sur votre infrastructure locale. Le deploiement est entièrement automatisé avec les cookbooks Ansible…

23 juil. 2021

Présentation de Cloudera Data Platform (CDP)

Catégories : Big Data, Cloud computing, Data Engineering | Tags : SDX, Big Data, Cloud, Cloudera, CDP, CDH, Analyse de données, Data Hub, Data Lake, Lakehouse, Entrepôt de données (Data Warehouse)

Cloudera Data Platform (CDP) est une plateforme de cloud computing pour les entreprises. CDP fournit des outils intégrés et multifonctionnels en libre-service afin d’analyser et de centraliser les…

19 juil. 2021

Python moderne, partie 3 : établir une chaîne de CI et publier son package sur PiPy

Catégories : DevOps & SRE | Tags : GitHub, CI/CD, Git, Python, Versions et évolutions, Tests unitaires

Avant de partager un package Python avec la communauté ou au sein de son organization, il est recommandé d’accomplir un certain nombres de tâches. Elles ont vocation à péréniser le bon fonctionnement…

Par BRAZA Faouzi

28 juin 2021

Python moderne, partie 2 : écrire les tests unitaires & respecter les conventions Git commit

Catégories : DevOps & SRE | Tags : Git, pandas, Python, Tests unitaires

L’application de bonnes pratiques en ingénierie logicielle apporte une plus-value certaine à vos projets. Par exemple l’écriture de tests unitaires vous permet de maintenir de larges projets en vous…

Par BRAZA Faouzi

24 juin 2021

Python moderne, partie 1 : création du projet avec pyenv & poetry

Catégories : DevOps & SRE | Tags : Git, Python, Versions et évolutions, Tests unitaires

L’apprentissage d’un langage de programmation se structure souvent autour de points essentiels : pratiquer la syntaxe du langage, en maîtriser le style, comprendre certains principes et paradigmes…

Par BRAZA Faouzi

9 juin 2021

Désacraliser le overlay filesystem de Linux dans Docker

Catégories : Orchestration de conteneurs, Infrastructure | Tags : DevOps, Système de fichiers, Linux, Docker

Le overlay filesystem (également appelés union filesystems) est une technologie fondamentale dans Docker pour créer des images et des conteneurs. Ils permettent de créer une union de répertoires pour…

Par WORMS David

3 juin 2021

Guide d'apprentissage pour vous former au Big Data & à L'IA avec la plateforme Databricks

Catégories : Data Engineering, Formation | Tags : Cloud, Data Lake, Databricks, Delta Lake, MLflow

Databricks Academy propose un programme de cours sur le Big Data, contenant 71 modules, que vous pouvez suivre à votre rythme et selon vos besoins. Il vous en coûtera 2000 $ US pour un accès illimité…

Par KNYAZEVA Anna

26 mai 2021

JS monorepos en prod 5 : fusion de plusieurs dépôts Git et préservation des commits

Catégories : DevOps & SRE, Node.js | Tags : Bash, DevOps, GitHub, Packaging, Git, GitOps, JavaScript, Monorepo

Chez Adaltas, nous maintenons plusieurs projets open-source Node.js organisés en monorepos Git et publiés sur NPM. Nous avons développé notre expérience avec les monorepos Lerna que nous partageons…

Par KUDINOV Sergei

21 mai 2021

Les certifications Microsoft Azure associées aux données

Catégories : Cloud computing, Data Engineering | Tags : Gouvernance des données, Azure, Data Science

Microsoft Azure a des parcours de certification pour de nombreux postes techniques tels que développeur, Data Engineers, Data Scientists et architect solution, entre autres. Chacune de ces…

Par NGOM Barthelemy

14 avr. 2021

Parcourir DBnomics avec GraphQL et connecter son schéma OpenAPI

Catégories : DevOps & SRE, Front End | Tags : Data Engineering, JAMstack, GraphQL, JavaScript, Node.js, REST, Schéma

Aujourd’hui, dans le cadre de la rédaction d’un long et fastidieux document, il était mentionné DBnomics, une plateforme ouverte fédérant des ensembles de données économiques. En parcourant son site…

Par WORMS David

8 avr. 2021

Apache Liminal, quand le MLOps rencontre le GitOps

Catégories : Big Data, Orchestration de conteneurs, Data Engineering, Data Science, Tech Radar | Tags : Data Engineering, CI/CD, Data Science, Deep Learning, Déploiement, Docker, GitOps, Kubernetes, Machine Learning, MLOps, Open source, Python, TensorFlow

Apache Liminal propose une solution clés en main permettant de déployer un pipeline de Machine Learning. C’est un projet open-source, qui centralise l’ensemble des étapes nécessaires à l’entrainement…

Par COINTEPAS Aargan

31 mars 2021

Espace de stockage et temps de génération des formats de fichiers

Catégories : Data Engineering, Data Science | Tags : Avro, HDFS, Hive, ORC, Parquet, Big Data, Data Lake, Format de fichier, JavaScript Object Notation (JSON)

Le choix d’un format de fichier approprié est essentiel, que les données soient en transit ou soient stockées. Chaque format de fichier a ses avantages et ses inconvénients. Nous les avons couverts…

Par NGOM Barthelemy

22 mars 2021

TensorFlow Extended (TFX) : les composants et leurs fonctionnalités

Catégories : Big Data, Data Engineering, Data Science, Formation | Tags : Beam, Data Engineering, Pipeline, CI/CD, Data Science, Deep Learning, Déploiement, Machine Learning, MLOps, Open source, Python, TensorFlow

La mise en production des modèles de Machine Learning (ML) et de Deep Learning (DL) est une tâche difficile. Il est reconnu qu’elle est plus sujette à l’échec et plus longue que la modélisation…

5 mars 2021

JS monorepos en prod 4 : tests unitaires avec Mocha et Should.js

Catégories : DevOps & SRE, Front End | Tags : Automation, CI/CD, Git, GitOps, Monorepo, Node.js, Tests unitaires

Les tests unitaires sont cruciaux pour tous les projets à long terme et permettent d’isoler des fonctionnalités de votre code en unités testables. En effet, l’objectif principal des tests unitaires…

Par WORMS David

25 févr. 2021

JS monorepos en prod 3 : validation de commits et generation du changelog

Catégories : DevOps & SRE, Front End | Tags : CI/CD, Git, JavaScript, Monorepo, Node.js, Versions et évolutions, Tests unitaires

Conventional Commits introduit un format structuré pour les message de commit. Il standardise les messages entre tous les contributeurs. Cela les rend plus lisibles et plus faciles à automatiser. Il…

Par WORMS David

2 févr. 2021

JS monorepos en prod 2 : gestion des versions et de la publication

Catégories : DevOps & SRE, Front End | Tags : CI/CD, Git, GitOps, JavaScript, Monorepo, Node.js, Versions et évolutions, Tests unitaires

Un des grands avantages d’un monorepo est de maintenir des versions cohérentes entre les packages et d’automatiser la création des versions et la publication des packages. Cet article couvre les…

Par WORMS David

11 janv. 2021

JS monorepos en prod 1 : initialization du projet

Catégories : DevOps & SRE, Front End | Tags : Git, GitOps, JavaScript, Monorepo, Node.js, Versions et évolutions

Chaque projet commence par l’étape d’initialisation. Lorsque votre projet est composé de plusieurs sous-projets, il est tentant de créer un dépôt Git par sous-projet. Dans Node.js, un sous-projet se…

Par WORMS David

5 janv. 2021

Construire votre distribution Big Data open source avec Hadoop, Hive, HBase, Spark et Zeppelin

Catégories : Big Data, Infrastructure | Tags : Maven, Hadoop, HBase, Hive, Spark, Git, Versions et évolutions, TDP, Tests unitaires

L’écosystème Hadoop a donné naissance à de nombreux projets populaires tels que HBase, Spark et Hive. Bien que des technologies plus récentes commme Kubernetes et les stockages objets compatibles S…

Par SCHOUKROUN Leo

18 déc. 2020

Développement accéléré de modèles avec H2O AutoML et Flow

Catégories : Data Science, Formation | Tags : Automation, Cloud, H2O, Machine Learning, MLOps, On-premises, Open source, Python

La construction de modèles de Machine Learning (ML) est un processus très consommateur de temps. De plus, il requière de bonne connaissance en statistique, en algorithme de ML ainsi qu’en…

10 déc. 2020

OAuth2 et OpenID Connect pour les microservices et les applications publiques (Partie 2)

Catégories : Orchestration de conteneurs, Cybersécurité | Tags : LDAP, Micro Services, CNCF, JavaScript Object Notation (JSON), OAuth2, OpenID Connect

En utilisant OAuth2 et OpenID Connect, il est important de comprendre comment se déroule le flux d’autorisation, qui appelle l’Authorization Server et comment stocker les tokens. De plus, les…

Par WORMS David

20 nov. 2020

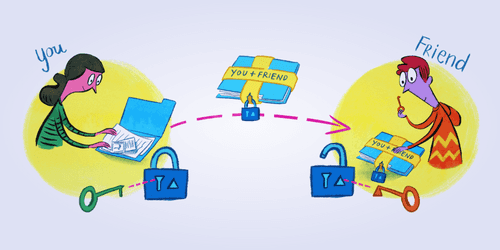

OAuth2 et OpenID Connect, une introduction douce et fonctionnelle (Part 1)

Catégories : Orchestration de conteneurs, Cybersécurité | Tags : Go Lang, JAMstack, LDAP, CNCF, Kubernetes, OAuth2, OpenID Connect

La compréhension d’OAuth2, d’OpenID et d’OpenID Connect (OIDC), comment ils sont liés, comment les communications sont établies, comment s’architecture votre application et que faire des différents…

Par WORMS David

17 nov. 2020

Connexion à ADLS Gen2 depuis Hadoop (HDP) et NiFi (HDF)

Catégories : Big Data, Cloud computing, Data Engineering | Tags : Hadoop, HDFS, NiFi, Authentification, Autorisation, Azure, Azure Data Lake Storage (ADLS), OAuth2

Alors que les projets Data construits sur le cloud deviennent de plus en plus répandus, un cas d’utilisation courant consiste à interagir avec le stockage cloud à partir d’une plateforme Big Data on…

Par LEONARD Gauthier

5 nov. 2020

Reconstruction de Hive dans HDP : patch, test et build

Catégories : Big Data, Infrastructure | Tags : Maven, GitHub, Java, Hive, Git, Versions et évolutions, TDP, Tests unitaires

La distribution HDP d’Hortonworks va bientôt être dépreciée a profit de la distribution CDP proposée par Cloudera. Un client nous a demandé d’intégrer d’une nouvelle feature de Apache Hive sur son…

Par SCHOUKROUN Leo

6 oct. 2020

Versionnage des données et ML reproductible avec DVC et MLflow

Catégories : Data Science, DevOps & SRE, Évènements | Tags : Data Engineering, Databricks, Delta Lake, Git, Machine Learning, MLflow, Storage

Notre présentation sur la gestion de versions sur des données et le développement reproductible d’algorithmes de Machine Learning proposé au Data + AI Summit (anciennement Spark + AI) est accepté. La…

30 sept. 2020

Suivi d'expériences avec MLflow sur Databricks Community Edition

Catégories : Data Engineering, Data Science, Formation | Tags : Spark, Databricks, Deep Learning, Delta Lake, Machine Learning, MLflow, Notebook, Python, Scikit-learn

Introduction au Databricks Community Edition et MLflow Chaque jour, le nombre d’outils permettant aux Data Scientists de créer des modèles plus rapidement augmente. Par conséquent, la nécessité de…

10 sept. 2020

Gestion des versions de vos jeux de données avec Data Version Control (DVC) et Git

Catégories : Data Science, DevOps & SRE | Tags : DevOps, Infrastructure, Exploitation, Git, GitOps, SCM

L’utilisation d’un système de contrôle de version tel que Git pour le code source est une bonne pratique et une norme de l’industrie. Étant donné que les projets se concentrent de plus en plus sur les…

Par JOUET Grégor

3 sept. 2020

Architecture de plugins en JavaScript et Node.js avec Plug and Play

Catégories : Front End, Node.js | Tags : Asynchrone, DevOps, Programmation, Agile, JavaScript, Open source, Versions et évolutions

Plug and Play aide les auteurs de bibliothèques et d’applications à introduire une architecture de plugins dans leur code. Il simplifie l’exécution de code complexe avec des points d’interception bien…

Par WORMS David

28 août 2020

Installation d'Hadoop depuis le code source : build, patch et exécution

Catégories : Big Data, Infrastructure | Tags : Maven, Java, LXD, Hadoop, HDFS, Docker, TDP, Tests unitaires

Les distributions commerciales d’Apache Hadoop ont beaucoup évolué ces dernières années. Les deux concurrents Cloudera et Hortonworks ont fusionné : HDP ne sera plus maintenu et CDH devient CDP. HP a…

Par SCHOUKROUN Leo

4 août 2020

Téléchargement de jeux de données dans HDFS et Hive

Catégories : Big Data, Data Engineering | Tags : Business Intelligence, Data Engineering, Data structures, Base de données, Hadoop, HDFS, Hive, Big Data, Analyse de données, Data Lake, Lakehouse, Entrepôt de données (Data Warehouse)

Introduction De nos jours, l’analyse de larges quantités de données devient de plus en plus possible grâce aux technologies du Big data (Hadoop, Spark,…). Cela explique l’explosion du volume de…

Par NGOM Aida

31 juil. 2020

Comparaison de différents formats de fichier en Big Data

Catégories : Big Data, Data Engineering | Tags : Business Intelligence, Data structures, Avro, HDFS, ORC, Parquet, Traitement par lots, Big Data, CSV, JavaScript Object Notation (JSON), Kubernetes, Protocol Buffers

Dans l’univers du traitement des données, il existe différents types de formats de fichiers pour stocker vos jeu de données. Chaque format a ses propres avantages et inconvénients selon les cas d…

Par NGOM Aida

23 juil. 2020

Automatisation d'un workflow Spark sur GCP avec GitLab

Catégories : Big Data, Cloud computing, Orchestration de conteneurs | Tags : Enseignement et tutorial, Airflow, Spark, CI/CD, GitLab, GitOps, GCP, Terraform

Un workflow consiste à automiatiser une succéssion de tâche qui dont être menée indépendemment d’une intervention humaine. C’est un concept important et populaire, s’appliquant particulièrement à un…

16 juin 2020

Importer ses données dans Databricks : tables externes et Delta Lake

Catégories : Data Engineering, Data Science, Formation | Tags : Parquet, AWS, Amazon S3, Azure Data Lake Storage (ADLS), Databricks, Delta Lake, Python

Au cours d’un projet d’apprentissage automatique (Machine Learning, ML), nous devons garder une trace des données test que nous utilisons. Cela est important à des fins d’audit et pour évaluer la…

21 mai 2020

Premier pas avec Apache Airflow sur AWS

Catégories : Big Data, Cloud computing, Orchestration de conteneurs | Tags : PySpark, Enseignement et tutorial, Airflow, Oozie, Spark, AWS, Docker, Python

Apache Airflow offre une solution répondant au défi croissant d’un paysage de plus en plus complexe d’outils de gestion de données, de scripts et de traitements d’analyse à gérer et coordonner. C’est…

Par COINTEPAS Aargan

5 mai 2020

Exposer un cluster Ceph basé sur Rook à l'extérieur de Kubernetes

Catégories : Orchestration de conteneurs | Tags : Debug, Rook, Ceph, Docker, Kubernetes

Nous avons récemment créé un cluster Hadoop basé sur des containers LXD et nous voulions être en mesure d’appliquer des quotas sur certains filesystems (par exemple : logs de service, repertoires…

Par SCHOUKROUN Leo

16 avr. 2020

Snowflake, le Data Warehouse conçu pour le cloud, introduction et premiers pas

Catégories : Business Intelligence, Cloud computing | Tags : Cloud, Data Lake, Data Science, Entrepôt de données (Data Warehouse), Snowflake

Snowflake est une plateforme d’entrepôt de données en mode SaaS qui centralise, dans le cloud, le stockage et le traitement de données structurées et semi-structurées. La génération croissante de…

7 avr. 2020

Optimisation d'applicationS Spark dans Hadoop YARN

Catégories : Data Engineering, Formation | Tags : Performance, Hadoop, Spark, Python

Apache Spark est un outil de traitement de données in-memory très répandu en entreprise pour traiter des problématiques Big Data. L’exécution d’une application Spark en production nécessite des…

30 mars 2020

MLflow tutorial : une plateforme de Machine Learning (ML) Open Source

Catégories : Data Engineering, Data Science, Formation | Tags : AWS, Azure, Databricks, Deep Learning, Déploiement, Machine Learning, MLflow, MLOps, Python, Scikit-learn

Introduction et principes de MLflow Avec une puissance de calcul et un stockage de moins en moins chers et en même temps une collecte de données de plus en plus importante dans tous les domaines, de…

23 mars 2020

Introduction à Ludwig et comment déployer un modèle de Deep Learning via Flask

Catégories : Data Science, Tech Radar | Tags : Enseignement et tutorial, Deep Learning, Machine Learning, Machine Learning, Python

Au cours de la dernière décennie, les modèles de Machine Learning et de Deep Learning se sont révélés très efficaces pour effectuer une grande variété de tâches tels que la détection de fraudes, la…

2 mars 2020

Installer et débugger Kubernetes dans LXD

Catégories : Orchestration de conteneurs | Tags : Debug, Linux, LXD, Docker, Kubernetes, Noeud

Nous avons récemment déployé des clusters Kubernetes avec le besoin de collocalliser les clusters sur des noeuds physiques au sein de nos infrastructures. Nous aurions pu utiliser des machines…

Par SCHOUKROUN Leo

4 févr. 2020

Sécurisation des services avec Open Policy Agent

Catégories : Cybersécurité, Gouvernance des données | Tags : Ranger, Kafka, Autorisation, Cloud, Kubernetes, REST, SSL/TLS

Open Policy Agent est un un moteur de règles multifonction. L’objectif principal du projet est de centraliser l’application de règles de sécurité à travers la stack cloud native. Le projet a été crée…

Par SCHOUKROUN Leo

22 janv. 2020

Cloudera CDP et migration Cloud de votre Data Warehouse

Catégories : Big Data, Cloud computing | Tags : Azure, Cloudera, Data Hub, Data Lake, Entrepôt de données (Data Warehouse)

Alors que l’un de nos clients anticipe un passage vers le Cloud et avec l’annonce récente de la disponibilité de Cloudera CDP mi-septembre lors de la conférence Strata, il semble que le moment soit…

Par WORMS David

16 déc. 2019

Configuration à distance et auto-indexage des pipelines Logstash

Catégories : Data Engineering, Infrastructure | Tags : Docker, Elasticsearch, Kibana, Logstash, Log4j

Logstash est un puissant moteur de collecte de données qui s’intègre dans la suite Elastic (Elasticsearch - Logstash - Kibana). L’objectif de cet article est de montrer comment déployer un cluster…

13 déc. 2019

Migration Big Data et Data Lake vers le Cloud

Catégories : Big Data, Cloud computing | Tags : DevOps, AWS, Azure, Cloud, CDP, Databricks, GCP

Est-il impératif de suivre tendance et de migrer ses données, workflow et infrastructure vers l’un des Cloud providers tels que GCP, AWS ou Azure ? Lors de la Strata Data Conference à New-York, un…

Par RUMMENS Joris

9 déc. 2019

Hadoop Ozone partie 1: introduction du nouveau système de fichiers

Catégories : Infrastructure | Tags : HDFS, Ozone, Cluster, Kubernetes

Hadoop Ozone est système de stockage d’objet pour Hadooop. Il est conçu pour supporter des milliards d’objets de tailles diverses. Il est actuellement en développement. La feuille de route est…

3 déc. 2019

Hadoop Ozone partie 3: Stratégie de réplication avancée avec les Copyset

Catégories : Infrastructure | Tags : HDFS, Ozone, Cluster, Kubernetes, Noeud

Hadoop Ozone propose de configurer le type de réplication à chaque écriture effectué sur le cluster. Actuellement seules HDFS et Ratis sont disponibles mais des stratégies plus avancées sont…

3 déc. 2019

Hadoop Ozone partie 2: tutorial et démonstration des fonctionnalités

Catégories : Infrastructure | Tags : CLI, Enseignement et tutorial, HDFS, Ozone, Amazon S3, Cluster, REST

Les versions d’Hadoop Ozone sont livrées avec des fichiers docker-compose très pratique pour tester Ozone. Les instructions ci-dessous apportent des détails sur comment les utiliser. Il est aussi…

3 déc. 2019

Stage Data Science & Data Engineer - ML en production et ingestion streaming

Catégories : Data Engineering, Data Science | Tags : DevOps, Flink, Hadoop, HBase, Kafka, Spark, Internship, Kubernetes, Python

Contexte L’évolution exponentielle des données a bouleversé l’industrie en redéfinissant les méthodes de stockages, de traitement et d’acheminement des données. Maitriser ces méthodes facilite…

Par WORMS David

26 nov. 2019

Stage InfraOps & DevOps - construction d'une offre PaaS Big Data & Kubernetes

Catégories : Big Data, Orchestration de conteneurs | Tags : DevOps, LXD, Hadoop, Kafka, Spark, Ceph, Internship, Kubernetes, NoSQL

Contexte L’acquisition d’un cluster à forte capacité répond à la volonté d’Adaltas de construire une offre de type PAAS pour disposer et mettre à disposition des plateformes de Big Data et d…

Par WORMS David

26 nov. 2019

Insérer des lignes dans une table BigQuery avec des colonnes complexes

Catégories : Cloud computing, Data Engineering | Tags : GCP, BigQuery, Schéma, SQL

Le service BigQuery de Google Cloud est une solution data warehouse conçue pour traiter d’énormes volumes de données avec un certain nombre de fonctionnalités disponibles. Parmi toutes celles-ci, nous…

Par BEREZOWSKI César

22 nov. 2019

Éviter les blocages dans les pipelines distribués de Deep Learning avec Horovod

Catégories : Data Science | Tags : GPU, Deep Learning, Horovod, Keras, TensorFlow

L’entraînement des modèles Deep Learning peut être grandement accéléré en utilisant un cluster de GPUs. Lorsqu’il s’agit de grandes quantités de données, effectuer des calculs distribués devient…

Par JOUET Grégor

15 nov. 2019

Authentification Kerberos et Spnego sur Windows avec Firefox

Catégories : Cybersécurité | Tags : Firefox, HTTP, FreeIPA, Kerberos

Dans la mythologie grecque, Kerberos, aussi appelé Cerbère, garde les portes du monde souterrain pour empêcher les morts de partir. Il est communément décrit comme un chien à trois têtes ayant une…

Par WORMS David

4 nov. 2019

Notes sur le nouveau modèle de licences Open Source de Cloudera

Catégories : Big Data | Tags : CDSW, Licence, Cloudera Manager, Open source

Suite à la publication de sa stratégie de licences Open Source le 10 juillet 2019 dans un article intitulé “notre engagement envers les logiciels Open Source”, Cloudera a diffusé un webinaire hier le…

Par WORMS David

25 oct. 2019

Innovation, culture projet vs culture produit en Data Science

Catégories : Data Science, Gouvernance des données | Tags : DevOps, Agile, Scrum

La Data Science porte en elle le métier de demain. Elle est étroitement liée à la compréhension du métier, des comportements et de l’intelligence qu’on tirera des données existantes. Les enjeux sont à…

Par WORMS David

8 oct. 2019

Mise en production d'un modèle de Machine Learning

Catégories : Big Data, Data Engineering, Data Science, DevOps & SRE | Tags : DevOps, Exploitation, IA, Cloud, Machine Learning, MLOps, On-premises, Schéma

“Le Machine Learning en entreprise nécessite une vision globale […] du point de vue de l’ingénierie et de la plateforme de données”, a expliqué Justin Norman lors de son intervention sur le…

Par RYNKIEWICZ Oskar

30 sept. 2019

Rook via Ceph n'approvisionne pas mes Persistent Volume Claims !

Catégories : DevOps & SRE | Tags : PVC, Linux, Rook, Ubuntu, Ceph, Cluster, Internship, Kubernetes

L’installation de Ceph dans un cluster Kubernetes peut être automatisé par l’utilisation de Rook. Actuellement en stage chez Adaltas, j’étais en charge de participer à la configuration d’un cluster…

Par CHOJNOWSKI Eyal

9 sept. 2019

Utilisateurs et autorisations RBAC dans Kubernetes

Catégories : Orchestration de conteneurs, Gouvernance des données | Tags : Cybersécurité, RBAC, Authentification, Autorisation, Kubernetes, SSL/TLS

Le déploiement d’un cluster Kubernetes n’est que le début de votre parcours et vous devez maintenant l’exploiter. Pour sécuriser son accès, les identités des utilisateurs doivent être déclarées avec…

7 août 2019

Installation de TensorFlow avec Docker

Catégories : Orchestration de conteneurs, Data Science, Formation | Tags : CPU, Linux, IA, Deep Learning, Docker, Jupyter, TensorFlow

TensorFlow est un logiciel open source de Google pour le calcul numérique utilisant une représentation en graph : Vertex (nodes) représentent des opérations mathématiques Edges représentent un tableau…

Par SAUVAGE Pierre

5 août 2019

Apache Hive 3, nouvelles fonctionnalités et conseils et astuces

Catégories : Big Data, Business Intelligence, DataWorks Summit 2019 | Tags : Druid, JDBC, LLAP, Hadoop, Hive, Kafka, Versions et évolutions

Disponible depuis juillet 2018 avec HDP3 (Hortonworks Data Platform 3), Apache Hive 3 apporte de nombreuses fonctionnalités intéressantes à l’entrepôt de données. Malheureusement, comme beaucoup de…

Par LEONARD Gauthier

25 juil. 2019

Auto-scaling de Druid avec Kubernetes

Catégories : Big Data, Business Intelligence, Orchestration de conteneurs | Tags : EC2, Druid, Helm, Métriques, OLAP, Exploitation, Orchestration de conteneurs, Cloud, CNCF, Analyse de données, Kubernetes, Prometheus, Python

Apache Druid est un système de stockage de données open-source destiné à l’analytics qui peut profiter des capacités d’auto-scaling de Kubernetes de par son architecture distribuée. Cet article est…

Par SCHOUKROUN Leo

16 juil. 2019

Activer Aladdin eToken dans Firefox sur Archlinux

Catégories : Hack | Tags : Arch Linux, Cybersécurité, Firefox, sécurité, Carte à puce, 2FA

Si comme moi vous êtes sur Archlinux et que vous disposez d’un eToken Aladdin pour vous authentifier, voyons comment nous pouvons le monter dans Firefox pour l’authentification Web. Un eToken Aladdin…

Par BEREZOWSKI César

12 juil. 2019

Spark Streaming partie 4 : clustering avec Spark MLlib

Catégories : Data Engineering, Data Science, Formation | Tags : Apache Spark Streaming, Spark, Big Data, Clustering, Machine Learning, Scala, Streaming

Spark MLlib est une bibliothèque Spark d’Apache offrant des implémentations performantes de divers algorithmes d’apprentissage automatique supervisés et non supervisés. Ainsi, le framework Spark peut…

Par RYNKIEWICZ Oskar

27 juin 2019

Notes du Google Cloud Summit à Paris

Catégories : Évènements | Tags : AWS, Azure, Cloud, GCP, Kubernetes, On-premises

Le 18 Juin avait lieu l’édition 2019 du salon annuel de Google à Paris. L’édition Parisienne de cette année a été la plus grande jusqu’à maintenant, ce qui reflète l’engagement de Google à se…

Par SAHNOUNI Tariq

26 juin 2019

Intégration de Druid et Hive

Catégories : Big Data, Business Intelligence, Tech Radar | Tags : Druid, LLAP, OLAP, Hive, Analyse de données, SQL

Nous allons dans cet article traiter de l’intégration entre Hive Interactive (LLAP) et Druid. Cet article est un complément à l’article Ultra-fast OLAP Analytics with Apache Hive and Druid.…

Par SAUVAGE Pierre

17 juin 2019

Spark Streaming partie 3 : DevOps, outils et tests pour les applications Spark

Catégories : Big Data, Data Engineering, DevOps & SRE | Tags : Apache Spark Streaming, DevOps, Enseignement et tutorial, Spark

L’indisponibilité des services entraîne des pertes financières pour les entreprises. Les applications Spark Streaming ne sont pas exempts de pannes, comme tout autre logiciel. Une application…

Par RYNKIEWICZ Oskar

31 mai 2019

Spark Streaming Partie 2 : traitement d'une pipeline Spark Structured Streaming dans Hadoop

Catégories : Data Engineering, Formation | Tags : Apache Spark Streaming, Spark, Python, Streaming

Spark est conçu pour traiter des données streaming de manière fluide sur un cluster Hadoop multi-nœuds, utilisant HDFS pour le stockage et YARN pour l’orchestration de tâches. Ainsi, Spark Structured…

Par RYNKIEWICZ Oskar

28 mai 2019

Spark Streaming partie 1 : construction de data pipelines avec Spark Structured Streaming

Catégories : Data Engineering, Formation | Tags : Apache Spark Streaming, Kafka, Spark, Big Data, Streaming

Spark Structured Streaming est un nouveau moteur de traitement stream introduit avec Apache Spark 2. Il est construit sur le moteur Spark SQL et utilise le modèle Spark DataFrame. Le moteur Structured…

Par RYNKIEWICZ Oskar

18 avr. 2019

Réinstaller une partition EFI sur un serveur dédié

Catégories : Hack | Tags : Infrastructure, Linux, Cloud

Nous avons récemment eu quelques difficultés avec la partition EFI d’un serveur dédié. Après un redémarrage, il n’est pas revenu en ligne. Si vous avez un serveur dédié chez votre hébergeur, vous êtes…

Par JOUET Grégor

16 avr. 2019

Les fonctions de première classe en Python

Catégories : Hack, Formation | Tags : Programmation, Python

J’ai récemment regardé une conférence de Dave Cheney sur les fonctions de première classe en Go. Sachant que Python est également capable de les prendre en charge, sont-elles utilisables de la même…

Par BUSSER Arthur

15 avr. 2019

Gatbsy.js, React et GraphQL pour nos documentations

Catégories : Adaltas Summit 2018, Front End | Tags : Gatsby, HTTP, JAMstack, React.js, SEO, API, GitOps, GraphQL, JavaScript, Markdown, Node.js

Au cours des derniers mois, j’ai consacrer un peu de temps à la ré-écritures de quelques sites Web pour nos projets Open Source. Ces sites incluent le projet CSV de Node.js, le client HBase pour Node…

Par WORMS David

1 avr. 2019

Publier Spark SQL Dataframe et RDD avec Spark Thrift Server

Catégories : Data Engineering | Tags : Thrift, JDBC, Hadoop, Hive, Spark, SQL

La nature distribuée et en-mémoire du moteur de traitement Spark en fait un excellant candidat pour exposer des données à des clients qui souhaitent des latences faibles. Les dashboards, les notebooks…

Par RYNKIEWICZ Oskar

25 mars 2019

Multihoming avec Hadoop

Catégories : Infrastructure | Tags : Hadoop, HDFS, Kerberos, Réseau

Le multihoming, qui implique l’association de plusieurs réseaux à un nœud, permet de gérer l’utilisation de réseaux hétérogènes dans un cluster Hadoop. Cet article est une introduction au concept de…

Par RUMMENS Joris

5 mars 2019

Introduction à Cloudera Data Science Workbench

Catégories : Data Science | Tags : Azure, Cloudera, Docker, Git, Kubernetes, Machine Learning, MLOps, Notebook

Cloudera Data Science Workbench est une plateforme qui permet aux Data Scientists de créer, gérer, exécuter et planifier des workflows de Data Science à partir de leur navigateur. Cela leur permet…

Par ELALAMI Mehdi

28 févr. 2019

Apache Knox, c'est facile !

Catégories : Big Data, Cybersécurité, Adaltas Summit 2018 | Tags : Ranger, LDAP, Active Directory, Knox, Kerberos, REST

Apache Knox est le point d’entrée sécurisé d’un cluster Hadoop, mais peut-il être également le point d’entrée de mes applications REST ? Vue d’ensemble d’Apache Knox Apache Knox est une passerelle…

Par HATOUM Michael

4 févr. 2019

Installation de Kubernetes sur CentOS 7

Catégories : Orchestration de conteneurs | Tags : CentOS, cgroups, DevOps, Infrastructure, Namespaces, Red Hat, VM, Ceph, CNCF, Docker, Kubernetes

Cet article présente la démarche à suivre afin d’installer un cluster Kubernetes. Chaque étape sera détaillée afin que ayez une compréhension approfondie de chacune d’elle. Cet article s’appuie sur ma…

Par BUSSER Arthur

29 janv. 2019

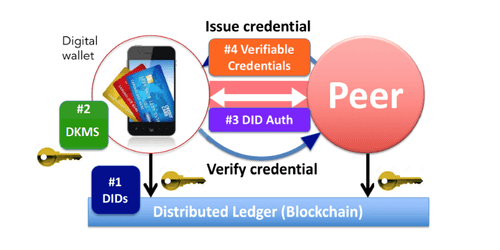

Les identités auto-souveraines

Catégories : Gouvernance des données | Tags : Authentification, Blockchain, Cloud, IAM, Livre de compte (ledger)

Vers une identité numérique fiable, personnelle, persistante et portable pour tous. Problèmes d’identité numérique Les identités auto-souveraines sont une tentative de redéfinir le notion d’identité…

Par MELLAL Nabil

23 janv. 2019

Apprentissage par renforcement appliqué au jeu de Poker

Catégories : Data Science | Tags : Algorithme, Jeu, Q-learning, Deep Learning, Machine Learning, Réseau de neurones, Python

Dans cet article, nous présenterons le “Deep Reinforcement Learning”, et plus particulièrement l’algorithme de Deep Q Learning introduit par DeepMind il y a quelques années. Dans une seconde partie…

9 janv. 2019

LXD : la pièce manquante

Catégories : Orchestration de conteneurs | Tags : CPU, Linux, LXD, VM, Docker, Kubernetes

LXD signifie Linux Container Daemon. Il s’agit d’une technologie de conteneur. Mais LXD est très différent. Il se distingue du peloton. Ce n’est pas nécessairement mieux ni beaucoup plus rapide ni…

Par SAHNOUNI Tariq

28 déc. 2018

Surveillance d'un cluster Hadoop de production avec Kubernetes

Catégories : DevOps & SRE | Tags : Thrift, Shinken, Hadoop, Knox, Cluster, Docker, Elasticsearch, Grafana, Kubernetes, Noeud, Node.js, Prometheus, Python

La surveillance d’un cluster Hadoop de production est un vrai challenge et se doit d’être en constante évolution. Aujourd’hui, la solution que nous utilisons se base sur Nagios. Efficace en ce qui…

21 déc. 2018

CodaLab - Concours de Data Science

Catégories : Data Science, Adaltas Summit 2018, Formation | Tags : Base de données, Infrastructure, Machine Learning, MySQL, Node.js, Python

CodaLab Competition est une plateforme servant à l’exécution de code dans le domaine de la Data Science. Elle se présente sous la forme d’une interface web sur laquelle un utilisateur peut soumettre…

17 déc. 2018

Les modules natifs Node.js avec N-API

Catégories : Adaltas Summit 2018, Front End | Tags : C++, NPM, JavaScript, Kerberos, Node.js

Que sont les modules natifs pour Node.js et comment les créer ? Les addons C/C++ sont une fonctionnalité utile et puissante du runtime Node.js. Explorons-les depuis leurs fonctionnement, jusqu’à leur…

Par HERMAND Xavier

12 déc. 2018

Microsoft annonce Cloud Native Application Bundles

Catégories : Orchestration de conteneurs | Tags : CLI, Helm, Packaging, Docker, Kubernetes

Lors de la DockerCon EU 2018 à Barcelone, Matt Butcher, ingénieur principal chez Microsoft et inventeur de Helm, a présenté CNAB, Cloud Native Application Bundles, un format de packaging pour…

Par BUSSER Arthur

4 déc. 2018

Jumbo, le bootstrapper de clusters Hadoop

Catégories : Infrastructure | Tags : Ambari, Automation, Ansible, Cluster, Vagrant, HDP, REST

Présentation de Jumbo, un bootstrapper de cluster Hadoop pour les développeurs. Jumbo vous aide à déployer des environnements de développement pour les technologies Big Data. Il suffit de quelques…

Par LEONARD Gauthier

29 nov. 2018

Les principaux avantages de GraphQL comme alternative au REST

Catégories : Front End | Tags : gRPC, API, GraphQL, JavaScript Object Notation (JSON), Node.js, Registre, REST

GraphQL est basé sur une idée simple, déplacer l’assemblage d’une requête du serveur vers le client. Ce dernier voit l’ensemble du schéma fortement typé au lieu d’une multitude de services REST et…

Par WORMS David

27 nov. 2018

Node.js CSV version 4 - réécriture et performances

Catégories : Node.js | Tags : CLI, Data Engineering, Refactoring, CSV, Versions et évolutions

Nous publions aujourd’hui une nouvelle version majeure du projet CSV Parser pour Node.js. La version 4 est une réécriture complète du projet axée sur la performance. Il comporte également de nouvelles…

Par WORMS David

19 nov. 2018

Prise de contrôle d'un cluster Hadoop avec Apache Ambari

Catégories : Big Data, DevOps & SRE, Adaltas Summit 2018 | Tags : Ambari, Automation, iptables, Nikita, Systemd, Cluster, HDP, Kerberos, Noeud, Node.js, REST

Nous avons récemment migré un large cluster Hadoop de production installé “manuellement” vers Apache Ambari. Nous avons nommé cette opération “Ambari Takeover”. C’est un processus à risque et nous…

Par SCHOUKROUN Leo

15 nov. 2018

Gestion des identités utilisateurs sur clusters Big Data

Catégories : Cybersécurité, Gouvernance des données | Tags : LDAP, Active Directory, Ansible, FreeIPA, IAM, Kerberos

La sécurisation d’un cluster Big Data implique l’intégration ou le déploiement de services spécifiques pour stocker les utilisateurs. Certains utilisateurs sont spécifiques à un cluster lorsque d…

Par WORMS David

8 nov. 2018

Apache Flink : passé, présent et futur

Catégories : Data Engineering | Tags : Pipeline, Flink, Kubernetes, Machine Learning, SQL, Streaming

Apache Flink est une petite pépite méritant beaucoup plus d’attention. Plongeons nous dans son passé, son état actuel et le futur vers lequel il se dirige avec les keytones et présentations de la…

Par BEREZOWSKI César

5 nov. 2018

Une semaine à discuter techno isolés dans un riad Marocain

Catégories : Adaltas Summit 2018, Formation | Tags : CDSW, Gatsby, React.js, Flink, Hadoop, Knox, Data Science, Deep Learning, Kubernetes, Node.js

Adaltas organise sa première conférence entre les 22 et 26 Octobre. Au programme de ces 5 jours de conférence : discuter de technologie dans l’un des plus beau riad de Marrakech. Mélanger l’utile à l…

Par WORMS David

11 oct. 2018

Nvidia et l'IA embarqué

Catégories : Data Science | Tags : Caffe, GPU, NVIDIA, IA, Deep Learning, Edge computing, Keras, PyTorch, TensorFlow

Depuis un peu plus de quatre ans, beaucoup de sociétés investissent dans l’intelligence artificielle et plus particulièrement dans le Deep Learning et le Edge Computing. Alors que la théorie avance à…

Par HATI Yliess

10 oct. 2018

Déploiement d'un cluster Flink sécurisé sur Kubernetes

Catégories : Big Data | Tags : Chiffrement, Flink, HDFS, Kafka, Elasticsearch, Kerberos, SSL/TLS

Le déploiement sécurisée d’une application Flink dans Kubernetes, entraine deux options. En supposant que votre Kubernetes est sécurisé, vous pouvez compter sur la plateforme sous-jacente ou utiliser…

Par WORMS David

8 oct. 2018

Machines KVM pour Vagrant sur Archlinux

Catégories : DevOps & SRE | Tags : Arch Linux, KVM, Linux, Virtualisation, VM, Vagrant

Vagrant supporte différents providers pour gérer la virtualisation. Dans un environnement Linux, il est possible d’améliorer considérablement les performances des VMs en utilisant le provider libvirt…

Par LEONARD Gauthier

19 sept. 2018

Lando : résumé de conversation en Deep Learning

Catégories : Data Science, Formation | Tags : Micro Services, Open API, Deep Learning, Internship, Kubernetes, Réseau de neurones, Node.js

Lando : Les derniers maîtres des mots Lando est une application de résumé de réunion qui utilise les technologies de Speech To Text pour transcrire de l’audio en écrit et les technologies de Deep…

Par HATI Yliess

18 sept. 2018

Migration de cluster et de traitements entre Hadoop 2 et 3

Catégories : Big Data, Infrastructure | Tags : Shiro, Erasure Coding, Rolling Upgrade, HDFS, Spark, YARN, Docker

La migration de Hadoop 2 vers Hadoop 3 est un sujet brûlant. Comment mettre à niveau vos clusters, quelles fonctionnalités présentes dans la nouvelle version peuvent résoudre les problèmes actuels et…

Par BAKALIAN Lucas

25 juil. 2018

Deep learning sur YARN : lancer Tensorflow et ses amis sur des clusters Hadoop

Catégories : Data Science | Tags : GPU, Hadoop, MXNet, Spark, Spark MLlib, YARN, Deep Learning, PyTorch, TensorFlow, XGBoost

Avec l’arrivée de Hadoop 3, YARN offre plus de possibilités dans la gestion des ressources. Il est désormais possible de lancer des traitements de Deep Learning sur des GPUs dans des espaces dédiés du…

Par BIANCHERIN Louis

24 juil. 2018

Environnement de développement CoreOS avec Vagrant et VirtualBox

Catégories : Hack, Infrastructure | Tags : Arch Linux, CoreOS, Linux, VirtualBox, etcd, Vagrant

Suivre les instructions de CoreOS sur la façon de configurer un environnement de développement dans VirtualBox n’a pas bien fonctionné pour moi. Voici les étapes que j’ai suivies pour que Container…

Par BUSSER Arthur

20 juin 2018

Remède à l'aveuglement de Kafka

Catégories : Big Data | Tags : Ambari, Ranger, Hortonworks, HDF, JMX, UI, Kafka, HDP

Il est difficile de visualiser pour les développeurs, opérateurs et manageurs, ce qui se cache à l’intérieur des entrailles de Kafka. Cet article parle d’une nouvelle interface graphique bientôt…

Par BAKALIAN Lucas

20 juin 2018

Ingestion de Data Lake, quelques bonnes pratiques

Catégories : Big Data, Data Engineering | Tags : Gouvernance des données, HDF, Exploitation, Avro, Hive, NiFi, ORC, Spark, Data Lake, Format de fichier, Protocol Buffers, Registre, Schéma

La création d’un Data Lake demande de la rigueur et de l’expérience. Voici plusieurs bonnes pratiques autour de l’ingestion des données en batch et en flux continu que nous recommandons et mettons en…

Par WORMS David

18 juin 2018

Guide pour les dossiers chiffrés sur Keybase

Catégories : Cybersécurité, Hack | Tags : Cryptographie, Chiffrement, Système de fichiers, Keybase, PGP, Autorisation

Cet article est un guide sur l’utilisation des dossiers chiffrés de Keybase pour stocker et partager des fichiers. Keybase is un logiciel pour partager ses groupes, ses fichiers et ses messages. Son…

Par BUSSER Arthur

18 juin 2018

Accélérer vos requêtes avec les vues matérialisées dans Apache Hive

Catégories : Business Intelligence, DataWorks Summit 2018 | Tags : Calcite, Druid, OLAP, Hive, Versions et évolutions, SQL

Jesus Camacho Rodriguez a organisé une présentation “Accelerating query processing with materialized views in Apache Hive” sur une nouvelle fonctionnalité à venir dans Apache Hive 3.0 : les vues…

31 mai 2018

Apache Hadoop YARN 3.0 - État de l'art

Catégories : Big Data, DataWorks Summit 2018 | Tags : GPU, Hortonworks, Hadoop, HDFS, MapReduce, YARN, Cloudera, Data Science, Docker, Versions et évolutions

Cet article couvre la présentation ”Apache Hadoop YARN: state of the union” (YARN état de l’art) par Wangda Tan d’Hortonworks lors de la conférence DataWorks Summit 2018 Berlin (anciennement Hadoop…

Par BAKALIAN Lucas

31 mai 2018

YARN et le calcul distribué sur GPU pour le machine learning

Catégories : Data Science, DataWorks Summit 2018 | Tags : GPU, YARN, Machine Learning, Réseau de neurones, Storage

Dans cet article nous verrons les principes fondamentaux du Machine Learning et les outils actuellement utilisés pour exécuter ce type d’algorithmes, puis nous expliquerons comment un gestionnaire de…

Par JOUET Grégor

30 mai 2018

TensorFlow avec Spark 2.3 : Le Meilleur des Deux Mondes

Catégories : Data Science, DataWorks Summit 2018 | Tags : Mesos, C++, CPU, GPU, Performance, Spark, YARN, JavaScript, Keras, Kubernetes, Machine Learning, Python, TensorFlow

L’intégration de Tensorflow dans Spark apporte de nombreux bénéfices et crée de nombreuses opportunités. Cet article est basé sur une conférence du DataWorks Summit 2018 à Berlin. Cette conférence…

Par HATI Yliess

29 mai 2018

Apache Metron dans le monde réel

Catégories : Cybersécurité, DataWorks Summit 2018 | Tags : Algorithme, Solr, Storm, pcap, SGBDR, HDFS, Kafka, Metron, NiFi, Spark, Data Science, Elasticsearch, SQL

Apache Metron est une plateforme d’analyse et de stockage spécialisé dans la sécurité informatique. La conférence a été présentée par Dave Russell, ingénieur en chef des solutions - EMEA + APAC chez…

Par HATOUM Michael

29 mai 2018

Exécuter des workloads d'entreprise dans le Cloud avec Cloudbreak

Catégories : Big Data, Cloud computing, DataWorks Summit 2018 | Tags : Cloudbreak, Exploitation, Hadoop, AWS, Azure, GCP, HDP, OpenStack

Cet article se base sur la conférence de Peter Darvasi et Richard Doktorics “Running Enterprise Workloads in the Cloud” au DataWorks Summit 2018 à Berlin. Il présentera l’outil de déploiement…

Par RUMMENS Joris

28 mai 2018

Omid : Traitement de transactions scalables et hautement disponibles pour Apache Phoenix

Catégories : Big Data, DataWorks Summit 2018 | Tags : Omid, Phoenix, Transaction, ACID, HBase, SQL

Apache Omid fournit une couche transactionnelle au-dessus des bases de données clés/valeurs NoSQL. Crédits à Ohad Shacham pour son discours et son travail pour Apache Omid. Cet article est le résultat…

Par HERMAND Xavier

24 mai 2018

Apache Beam : un modèle de programmation unifié pour les pipelines de traitement de données

Catégories : Data Engineering, DataWorks Summit 2018 | Tags : Apex, Beam, Pipeline, Flink, Spark

Dans cet article, nous allons passer en revue les concepts, l’histoire et le futur d’Apache Beam, qui pourrait bien devenir le nouveau standard pour la définition des pipelines de traitement de…

Par LEONARD Gauthier

24 mai 2018

Quelles nouveautés pour Apache Spark 2.3 ?

Catégories : Data Engineering, DataWorks Summit 2018 | Tags : Arrow, PySpark, Performance, ORC, Spark, Spark MLlib, Data Science, Docker, Kubernetes, pandas, Streaming

Plongeons nous dans les nouveautés proposées par la nouvelle distribution 2.3 d’Apache Spark. Cette article est composé de recherches et d’informations issues des présentations suivantes du DataWorks…

Par BEREZOWSKI César

23 mai 2018

Le futur de l'orchestration de workflows dans Hadoop : Oozie 5.x

Catégories : Big Data, DataWorks Summit 2018 | Tags : Hadoop, Hive, Oozie, Sqoop, CDH, HDP, REST

Au DataWorks Summit Europe 2018 de Berlin, j’ai eu l’occasion d’assister à une session sur Apache Oozie. La présentation se concentre sur les caractéristiques du prochain Oozie 5.0 et celles à venir…

Par SCHOUKROUN Leo

23 mai 2018

Questions essentielles sur les base de données Time Series

Catégories : Big Data | Tags : Druid, HBase, Hive, ORC, Data Science, Elasticsearch, Grafana, IOT

Aujourd’hui, le gros des données Big Data est de nature temporelle. On le constate dans les médias comme chez nos clients : compteurs intelligents, transactions bancaires, usines intelligentes,…

Par WORMS David

18 mars 2018

Executer du Python dans un workflow Oozie

Catégories : Data Engineering | Tags : Oozie, Elasticsearch, Python, REST

Les workflows Oozie permettent d’utiliser plusieurs actions pour exécuter du code, cependant il peut être délicat d’exécuter du Python, nous allons voir comment faire. J’ai récemment implémenté un…

Par BEREZOWSKI César

6 mars 2018

Ambari - Comment utiliser les blueprints

Catégories : Big Data, DevOps & SRE | Tags : Ambari, Ranger, Automation, DevOps, Exploitation, REST

En tant qu’ingénieurs d’infrastructure chez Adaltas, nous déployons des clusters. Beaucoup de clusters. Généralement, nos clients choisissent d’utiliser une distribution telle que Hortonworks HDP ou…

Par RUMMENS Joris

17 janv. 2018

Notes sur Katacoda relatives à l'orchestrateur de conteneur Kubernetes

Catégories : Orchestration de conteneurs, Formation | Tags : Helm, Kubeadm, CNI, Micro Services, Minikube, Ingress, Kubernetes

Il y a quelques semaines, j’ai consacré deux jours pour suivre les cours relatifs à la solution d’orchestration de *container Kubernetes mis à disposition sur la plateforme Katacoda. Je partage ces…

Par WORMS David

14 déc. 2017

Passage à l'échelle de larges pipelines de données en temps réel avec Go

Catégories : Open Source Summit Europe 2017, Formation | Tags : Algorithme, Data structures, Go Lang, Pipeline, Protocols, Réseau

Il y a quelques semaines, à l’Open Source Summit à Prague, Jean de Klerk a tenu une conférence intitulée “Passage à l’échelle en temps réel de pipelines de données avec Go”. Cet article passe en revue…

Par BUSSER Arthur

21 nov. 2017

Introduction à MESOS

Catégories : Orchestration de conteneurs, Open Source Summit Europe 2017 | Tags : Mesos, GPU, Orchestration de conteneurs, CUDA, Data Science, Docker

Apache Mesos est un projet Open Source de gestion de clusters pensé pour mettre en place et optimiser des systèmes distribués. Mesos permet la gestion et le partage des ressources de manière fine et…

Par BIANCHERIN Louis

15 nov. 2017

Micro Services

Catégories : Cloud computing, Orchestration de conteneurs, Open Source Summit Europe 2017 | Tags : Mesos, DNS, Chiffrement, gRPC, Linkerd, Micro Services, MITM, Service Mesh, CNCF, Istio, Kubernetes, Proxy, SPOF, SSL/TLS

Historiquement, les applications étaient monolithiques et nous pouvions utiliser une adresse IP pour accéder à un service. Avec les machines virtuelles (VM), plusieurs hôtes commencent à apparaître…

Par WORMS David

14 nov. 2017

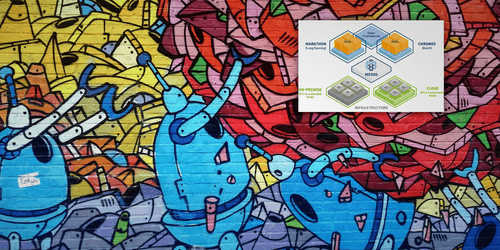

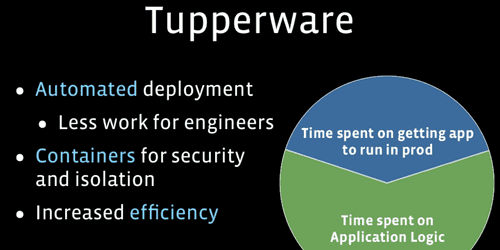

Orchestration de conteneurs chez Facebook avec Tupperware

Catégories : Orchestration de conteneurs, Open Source Summit Europe 2017, Infrastructure | Tags : Btrfs, LXD, Red Hat, Systemd, Zookeeper, Cloud, Consensus

Dans cet article, je présenterai la solution d’orchestration de conteneurs mise en place par Facebook, appelée Tupperware. Qu’est-ce que Tupperware ? Tupperware est un framework fait maison écrit et…

Par BAKALIAN Lucas

3 nov. 2017

Personne* ne met Java dans un containeur

Catégories : Orchestration de conteneurs, Open Source Summit Europe 2017, Infrastructure | Tags : cgroups, Java, JRE, JVM, Namespaces, Docker

Cette discussion porte sur les problèmes de mettre Java dans un conteneur et comment, dans sa dernière version 9, le JDK est maintenant plus conscient du conteneur dans lequel il s’exécute. La…

28 oct. 2017

Méthodes de stockage persistées dans Kubernetes

Catégories : Cloud computing, Orchestration de conteneurs, Open Source Summit Europe 2017 | Tags : Container Storage Interface (CSI), PVC, Azure, Docker, GCE, Kubernetes, Storage

Cet article est basé sur la présentation “Introduction to Kubernetes Storage Primitives for Stateful Workloads” par the {Code} team à la conférence OSS 2017 à Prague. Commençons par qu’est-ce que…

Par SAUVAGE Pierre

28 oct. 2017

Apache Thrift vs REST

Catégories : DevOps & SRE, Open Source Summit Europe 2017 | Tags : Thrift, gRPC, HTTP, JavaScript Object Notation (JSON), REST

Adaltas a récemment assisté à l’Open Source Summit Europe 2017 à Prague. J’ai eu l’occasion de suivre une présentation faite par Randy Abernethy et Jens Geyer de RM-X, une société de conseil en cloud…

Par SCHOUKROUN Leo

28 oct. 2017

Intégration continue et "gating" multi-repo à grand échelle

Catégories : Cloud computing, DevOps & SRE, Open Source Summit Europe 2017 | Tags : Infrastructure, Jenkins, Red Hat, Zuul, Ansible, CI/CD, OpenStack

Cet article est un récapitulatif avec nos impressions de la présentation de l’outil d’intégration continue d’OpenStack Zuul à la conférence Open Source Summit 2017 à Prague par Monty Taylor (à ne pas…

Par RUMMENS Joris

28 oct. 2017

De Dockerfile à Ansible Containers

Catégories : Orchestration de conteneurs, DevOps & SRE, Open Source Summit Europe 2017 | Tags : Shell, Ansible, Docker, Docker Compose, YAML

Cette présentation était une introduction au format Dockerfile et à l’outil Ansible Containers puis une comparaison des deux produits. Elle fut réalisée par Tomas Tomecek, membre de l’équipe…

Par BEREZOWSKI César

25 oct. 2017

Kubernetes 1.8

Catégories : Orchestration de conteneurs, Open Source Summit Europe 2017 | Tags : containerd, CRD, RBAC, Kubernetes, Réseau, OCI, Versions et évolutions

L’arrivée de Kubernetes 1.8 apporte son lot de nouveautés. Grâce à plus de 2500 pull requests, 2000 commits, avec environ 400 commiters, Kubernetes a su rajouter 39 fonctionnalités en plus à la…

Par YASSINE Younes

24 oct. 2017

Cloudera Sessions Paris 2017

Catégories : Big Data, Évènements | Tags : EC2, Altus, CDSW, SDX, Azure, Cloudera, CDH, Data Science, PaaS

Adaltas était présent le 5 octobre aux Cloudera Sessions, la journée de présentation des nouveaux produits Cloudera. Voici un compte rendu de ce que nous avons pu voir. Note : les informations ont été…

Par BEREZOWSKI César

16 oct. 2017

Le moteur Vespa de Yahoo

Catégories : Tech Radar | Tags : Base de données, Tools, Elasticsearch, Search Engine

Vespa est le moteur de services et de traitements big data complètement autonome et autosuffisant de Yahoo. Il a pour but de servir les résultats de requêtes sur d’énorme quantité de données en temps…

Par BUSSER Arthur

16 oct. 2017

MariaDB integration with Hadoop

Catégories : Infrastructure | Tags : Base de données, HA, MariaDB, Hadoop, Hive

Lors d’ateliers menés avec l’un de nos clients, Adaltas a levé un risque potentiel sur la stratégie utilisée pour la mise en haute disponibilité (HA) de MariaDB. Le client ayant sélectionné la…

Par WORMS David

31 juil. 2017

Exposition de brokers Kafka sur deux interfaces réseaux

Catégories : Infrastructure | Tags : Cybersécurité, VLAN, Kafka, Cloudera, CDH, Réseau

Une installation Big Data nécessite généralement d’avoir plusieurs interfaces réseaux, nous allons voir comment paramétrer Kafka pour écouter sur plus d’une. La procédure décrite dans cette article a…

Par BEREZOWSKI César

22 juil. 2017

Synchronisation Oracle vers Hadoop avec un CDC

Catégories : Data Engineering | Tags : CDC, GoldenGate, Oracle, Hive, Sqoop, Entrepôt de données (Data Warehouse)

Cette note résulte d’une discussion autour de la synchronisation de données écrites dans une base de données à destination d’un entrepôt stocké dans Hadoop. Merci à Claude Daub de GFI qui la rédigea…

Par WORMS David

13 juil. 2017

Changer la couleur de la topbar d'Ambari

Catégories : Big Data, Hack | Tags : Ambari, Front-end

J’étais récemment chez un client qui a plusieurs environnements (Prod, Integration, Recette, …) sur HDP avec chacun son instance Ambari. L’une des questions soulevée par le client est la suivante…

Par BEREZOWSKI César

9 juil. 2017

MiNiFi : Scalabilité de la donnée & de l'intérêt de commencer petit

Catégories : Big Data, DevOps & SRE, Infrastructure | Tags : MiNiFi, C++, HDF, NiFi, Cloudera, HDP, IOT