Gouvernance des données

La gouvernance représente un ensemble de procédures garantissant que les données importantes sont formellement gérées au travers de l’entreprise.

Elle garantit la confiance dans les données et la responsabilité des utilisateurs en cas d’impact lié à la mauvaise qualité des données. Elle prend toute son importance dans une plateforme Big Data dont la vocation est de faire coexister sur une même plateforme plusieurs sources de données, plusieurs traitements et plusieurs utilisateurs.

Organisation, responsabilités

Une organisation juste de l’humain facilite la communication et la compréhension entre équipes, cible la promotion d’une culture agile de la donnée et instaure de nouvelles responsabilités (Chief Data Officer, Data Council, Data Steward,…) en imposant un seul point de responsabilité.

Autorisation/ACL

Chacun des composants du cluster possède par nature ses propres mécanismes de contrôle d’accès. Des permissions fines appliquées à un système de fichier ne se gère pas commes celles d'une base de données relationnelle. Ces règles peuvent se baser sur des rôles (RBAC), sur des tags ou encore sur la géolocalisation d'adresse IP.

Identité, authentification

La gestion des identités inclut les données utilisateurs et leur existence, leurs appartenance à des groupes et des règles de gestion qui leurs sont appliquées. Elle s’appuie sur le référentiel de l’entreprise et l’intégration de la plateforme cible avec le serveur LDAP ou l’Active Directory de l’entreprise.

Nommage

Il appartient au client de définir un ensemble de règles de nommage pour assurer l’intégrité et la cohérence du système. L’objectif est d’assurer les utilisateurs business ou techniques de la compréhension des noms tout en préservant les mêmes conventions, structures et termes. Les critères d’attribution sont : avoir du sens, être compréhensible sans explication externe, refléter l’utilisation des ressources qu’il adresse, se différencier des autres noms autant que possible, maximiser l’utilisation de nom complet dans la mesure du possible, utiliser les mêmes abréviations, employer le singulier.

Metadonnées, traçabilité

L’utilisation d’information additionnelles comme les tags permet de suivre la donnée tout au long de son cycle de vie: alimentation, qualification, enrichissement, exposition. Cette traçabilité témoigne d’où vient la donnée, par où est-elle passée, quelles sont les personnes/applications qui y ont eu accès et comment a-t-elle été altérée. La remontée de métadonnées systématique permet de classifier les données, centraliser la capture des comportements utilisateur et applicatifs, suivre et fouiller les actions appliquées à la donnée, s’assurer de la conformité des usages vis à vis des politiques de sécurité en place.

Qualité de la donnée

Les équipes métiers sont responsables de qualifier la donnée. Des interlocuteurs uniques doivent être en mesure de rendre des comptes et d’endosser d’éventuelles responsabilités. Il est important de constituer une chaine de devoirs lisible par tous dans laquelle les responsabilités ne sont pas partagées. Les équipes pourront s’appuyer sur les mécanismes d’outils existant pour valider le format et l’application d’un schéma à chaque enregistrement. De plus, les outils sélectionnés doivent décrire les qualité attendues et prévenir de la corruption des données tant au repos qu’en transit.

Allocation des ressources

Dans une architecture multi-tenant, l'orchestrateur porte la responsabilité de garantir la disponibilité des ressources allouées à certains utilisateurs ou groupes d’utilisateurs. YARN et Kubernetes peuvent ainsi restreinte la disponiblité de ressource mémoire et CPU d'une application. L’exécution de processus est conditionnée à l’appartenance de l’utilisateur à certaines espaces bénéficiant d’un accès plus ou moins restreint aux ressources du serveur. Il garantit la disponibilité des ressources allouées à chaque utilisateur.

Cycle de vie de la donnée

Appelée Information Lifecycle Management (ILM) en anglais, la gestion du cycle de vie de la donnée peut se gérer tout au long de la chaîne d’alimentation et de traitement. Son rôle est de planifier l’alimentation et les traitements entre un et plusieurs espaces, de stocker et d’archiver la donnée ainsi que de garantir et de préserver les durées de rétention.

Articles associés à la gouvernance des données

Introduction to OpenLineage

Catégories : Big Data, Data Governance, Infrastructure | Tags : Data Engineering, Infrastructure, Atlas, Data Lake, Data lakehouse, Data Warehouse, Data lineage

OpenLineage is an open-source specification for data lineage. The specification is complemented by Marquez, its reference implementation. Since its launch in late 2020, OpenLineage has been a presence…

19 févr. 2024

CDP part 5: user permissions management on CDP Public Cloud

Catégories : Big Data, Cloud Computing, Data Governance | Tags : Ranger, Cloudera, CDP, Data Warehouse

When you create a user or a group in CDP, it requires permissions to access resources and use the Data Services. This article is the fifth in a series of six: CDP part 1: introduction to end-to-end…

Par Tobias CHAVARRIA

18 juil. 2023

CDP part 4: user management on CDP Public Cloud with Keycloak

Catégories : Big Data, Cloud Computing, Data Governance | Tags : EC2, Big Data, CDP, Docker Compose, Keycloak, SSO

Previous articles of the serie cover the deployment of a CDP Public Cloud environment. All the components are ready for use and it is time to make the environment available to other users to explore…

Par Tobias CHAVARRIA

4 juil. 2023

Ceph object storage within a Kubernetes cluster with Rook

Catégories : Big Data, Data Governance, Learning | Tags : Amazon S3, Big Data, Ceph, Cluster, Data Lake, Kubernetes, Storage

Ceph is a distributed all-in-one storage system. Reliable and mature, its first stable version was released in 2012 and has since then been the reference for open source storage. Ceph’s main perk is…

Par Luka BIGOT

4 août 2022

MinIO object storage within a Kubernetes cluster

Catégories : Big Data, Data Governance, Learning | Tags : Amazon S3, Big Data, Cluster, Data Lake, Kubernetes, Storage

MinIO is a popular object storage solution. Often recommended for its simple setup and ease of use, it is not only a great way to get started with object storage: it also provides excellent…

Par Luka BIGOT

9 juil. 2022

Architecture of object-based storage and S3 standard specifications

Catégories : Big Data, Data Governance | Tags : Database, API, Amazon S3, Big Data, Data Lake, Storage

Object storage has been growing in popularity among data storage architectures. Compared to file systems and block storage, object storage faces no limitations when handling petabytes of data. By…

Par Luka BIGOT

20 juin 2022

Policy enforcing with Open Policy Agent

Catégories : Cyber Security, Data Governance | Tags : Kafka, Ranger, Authorization, Cloud, Kubernetes, REST, SSL/TLS

Open Policy Agent is an open-source multi-purpose policy engine. Its main goal is to unify policy enforcement across the cloud native stack. The project was created by Styra and it is currently…

Par Leo SCHOUKROUN

22 janv. 2020

Innovation, project vs product culture in Data Science

Catégories : Data Science, Data Governance | Tags : DevOps, Agile, Scrum

Data Science carries the jobs of tomorrow. It is closely linked to the understanding of the business usecases, the behaviors and the insights that will be extracted from existing data. The stakes are…

Par David WORMS

8 oct. 2019

Users and RBAC authorizations in Kubernetes

Catégories : Containers Orchestration, Data Governance | Tags : Cyber Security, RBAC, Authentication, Authorization, Kubernetes, SSL/TLS

Having your Kubernetes cluster up and running is just the start of your journey and you now need to operate. To secure its access, user identities must be declared along with authentication and…

7 août 2019

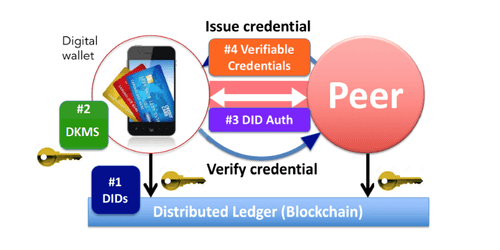

Self-sovereign identities with verifiable claims

Catégories : Data Governance | Tags : Authentication, Blockchain, Cloud, IAM, Ledger

Towards a trusted, personal, persistent, and portable digital identity for all. Digital identity issues Self-sovereign identities are an attempt to solve a couple of issues. The first is the…

Par Nabil MELLAL

23 janv. 2019

Managing User Identities on Big Data Clusters

Catégories : Cyber Security, Data Governance | Tags : LDAP, Active Directory, Ansible, FreeIPA, IAM, Kerberos

Securing a Big Data Cluster involves integrating or deploying specific services to store users. Some users are cluster-specific when others are available across all clusters. It is not always easy to…

Par David WORMS

8 nov. 2018

Managing authorizations with Apache Sentry

Catégories : Data Governance | Tags : Hue, Database, LDAP, Nikita, Sentry, Ansible, CDH, Deployment

Apache Sentry is a system for enforcing fine grained role based authorization to data and metadata stored on a Hadoop cluster. With this article, we will show you how we are using Apache Sentry at…

Par Axel JACQIN

24 juil. 2017

About the new BSD license and its difference with other BSD licenses

Catégories : Data Governance | Tags : License, Open source

As a non restrictive Open Source license, the “new BSD license” is a commonly used license across the Node.js community. However, this is only one of the BSD license available along the original “BSD…

Par David WORMS

8 août 2013