Apache Hive

Apache Hive est un système d'entrepôt de données distribué tolérant aux pannes basé sur Hadoop qui utilise un langage de type SQL appelé HiveSQL pour lire, écrire et analyser de grands ensembles de données. Hive a été conçu pour Online Analytical Processing (OLAP) et non pas pour Online Transaction Processing (OLTP).

Hive permet aux développeurs et aux utilisateurs de se servir d’une syntaxe et des fonctionnalités de type SQL pour l’extraction/transformation/chargement (ETL), le reporting et l’analyse de données. Les données peuvent ensuite être stockées dans divers formats dans differenetes bases de données Hadoop. Les requêtes HiveQL sont traduites dans le format requis pour le système de base de données. Hive fournit des opérations standard telles que filtrer, joindre ou agréger.

Contrairement aux bases de données relationnelles, Hive n'utilise pas l’approche schéma en écriture (SoW), mais l'approche schema-on-read (SoR).

Les données sont toujours stockées telles quelles dans Hadoop et ne sont vérifiées que sur demande par rapport à un schéma spécifique. Cela donne la possibilité de charger des données nettement plus rapide. De plus, différents schémas peuvent être utilisés pour la même base de données.

- En savoir plus

- Site officiel

Articles associés

Deux Hive UDAF pour convertir une aggregation vers une map

Catégories : Data Engineering | Tags : Java, HBase, Hive, Format de fichier

Je publie deux nouvelles fonctions UDAF pour Hive pour aider avec les map dans Apache Hive. Le code source est disponible sur GitHub dans deux classes Java : “UDAFToMap” et “UDAFToOrderedMap” ou vous…

Par WORMS David

6 mars 2012

Stockage HDFS et Hive - comparaison des formats de fichiers et compressions

Catégories : Data Engineering | Tags : Business Intelligence, Hive, ORC, Parquet, Format de fichier

Il y a quelques jours, nous avons conduit un test dans le but de comparer différents format de fichiers et méthodes de compression disponibles dans Hive. Parmi ces formats, certains sont natifs à HDFS…

Par WORMS David

13 mars 2012

Diviser des fichiers HDFS en plusieurs tables Hive

Catégories : Data Engineering | Tags : Flume, Pig, HDFS, Hive, Oozie, SQL

Je vais montrer comment scinder fichier CSV stocké dans HDFS en plusieurs tables Hive en fonction du contenu de chaque enregistrement. Le contexte est simple. Nous utilisons Flume pour collecter les…

Par WORMS David

15 sept. 2013

Hive, Calcite et Druid

Catégories : Big Data | Tags : Druid, Business Intelligence, Base de données, Hadoop, Hive

BI/OLAP est nécessaire à la visualisation interactive de flux de données : Évènements issus d’enchères en temps réel Flux d’activité utilisateur Log de téléphonie Suivi du trafic réseau Évènements de…

Par WORMS David

14 juil. 2016

Hive Metastore HA avec DBTokenStore : Failed to initialize master key

Catégories : Big Data, DevOps & SRE | Tags : Infrastructure, Hive, Bug

Cet article décrit ma petite aventure autour d’une erreur au démarrage du Hive Metastore. Elle se reproduit dans un environnement précis qui est celui d’une installation sécurisée, entendre avec…

Par WORMS David

21 juil. 2016

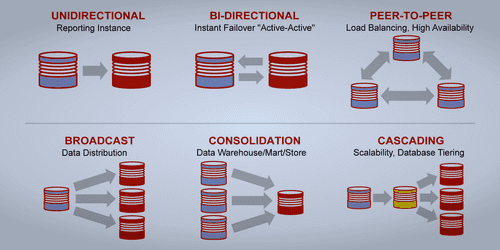

Synchronisation Oracle vers Hadoop avec un CDC

Catégories : Data Engineering | Tags : CDC, GoldenGate, Oracle, Hive, Sqoop, Entrepôt de données (Data Warehouse)

Cette note résulte d’une discussion autour de la synchronisation de données écrites dans une base de données à destination d’un entrepôt stocké dans Hadoop. Merci à Claude Daub de GFI qui la rédigea…

Par WORMS David

13 juil. 2017

MariaDB integration with Hadoop

Catégories : Infrastructure | Tags : Base de données, HA, MariaDB, Hadoop, Hive

Lors d’ateliers menés avec l’un de nos clients, Adaltas a levé un risque potentiel sur la stratégie utilisée pour la mise en haute disponibilité (HA) de MariaDB. Le client ayant sélectionné la…

Par WORMS David

31 juil. 2017

Questions essentielles sur les base de données Time Series

Catégories : Big Data | Tags : Druid, HBase, Hive, ORC, Data Science, Elasticsearch, Grafana, IOT

Aujourd’hui, le gros des données Big Data est de nature temporelle. On le constate dans les médias comme chez nos clients : compteurs intelligents, transactions bancaires, usines intelligentes,…

Par WORMS David

18 mars 2018

Le futur de l'orchestration de workflows dans Hadoop : Oozie 5.x

Catégories : Big Data, DataWorks Summit 2018 | Tags : Hadoop, Hive, Oozie, Sqoop, CDH, HDP, REST

Au DataWorks Summit Europe 2018 de Berlin, j’ai eu l’occasion d’assister à une session sur Apache Oozie. La présentation se concentre sur les caractéristiques du prochain Oozie 5.0 et celles à venir…

Par SCHOUKROUN Leo

23 mai 2018

Accélérer vos requêtes avec les vues matérialisées dans Apache Hive

Catégories : Business Intelligence, DataWorks Summit 2018 | Tags : Calcite, Druid, OLAP, Hive, Versions et évolutions, SQL

Jesus Camacho Rodriguez a organisé une présentation “Accelerating query processing with materialized views in Apache Hive” sur une nouvelle fonctionnalité à venir dans Apache Hive 3.0 : les vues…

31 mai 2018

Ingestion de Data Lake, quelques bonnes pratiques

Catégories : Big Data, Data Engineering | Tags : Gouvernance des données, HDF, Exploitation, Avro, Hive, NiFi, ORC, Spark, Data Lake, Format de fichier, Protocol Buffers, Registre, Schéma

La création d’un Data Lake demande de la rigueur et de l’expérience. Voici plusieurs bonnes pratiques autour de l’ingestion des données en batch et en flux continu que nous recommandons et mettons en…

Par WORMS David

18 juin 2018

Apache Knox, c'est facile !

Catégories : Big Data, Cybersécurité, Adaltas Summit 2018 | Tags : Ranger, LDAP, Active Directory, Knox, Kerberos, REST

Apache Knox est le point d’entrée sécurisé d’un cluster Hadoop, mais peut-il être également le point d’entrée de mes applications REST ? Vue d’ensemble d’Apache Knox Apache Knox est une passerelle…

Par HATOUM Michael

4 févr. 2019

Publier Spark SQL Dataframe et RDD avec Spark Thrift Server

Catégories : Data Engineering | Tags : Thrift, JDBC, Hadoop, Hive, Spark, SQL

La nature distribuée et en-mémoire du moteur de traitement Spark en fait un excellant candidat pour exposer des données à des clients qui souhaitent des latences faibles. Les dashboards, les notebooks…

Par RYNKIEWICZ Oskar

25 mars 2019

Intégration de Druid et Hive

Catégories : Big Data, Business Intelligence, Tech Radar | Tags : Druid, LLAP, OLAP, Hive, Analyse de données, SQL

Nous allons dans cet article traiter de l’intégration entre Hive Interactive (LLAP) et Druid. Cet article est un complément à l’article Ultra-fast OLAP Analytics with Apache Hive and Druid.…

Par SAUVAGE Pierre

17 juin 2019

Apache Hive 3, nouvelles fonctionnalités et conseils et astuces

Catégories : Big Data, Business Intelligence, DataWorks Summit 2019 | Tags : Druid, JDBC, LLAP, Hadoop, Hive, Kafka, Versions et évolutions

Disponible depuis juillet 2018 avec HDP3 (Hortonworks Data Platform 3), Apache Hive 3 apporte de nombreuses fonctionnalités intéressantes à l’entrepôt de données. Malheureusement, comme beaucoup de…

Par LEONARD Gauthier

25 juil. 2019

Hadoop Ozone partie 1: introduction du nouveau système de fichiers

Catégories : Infrastructure | Tags : HDFS, Ozone, Cluster, Kubernetes

Hadoop Ozone est système de stockage d’objet pour Hadooop. Il est conçu pour supporter des milliards d’objets de tailles diverses. Il est actuellement en développement. La feuille de route est…

3 déc. 2019

Premier pas avec Apache Airflow sur AWS

Catégories : Big Data, Cloud computing, Orchestration de conteneurs | Tags : PySpark, Enseignement et tutorial, Airflow, Oozie, Spark, AWS, Docker, Python

Apache Airflow offre une solution répondant au défi croissant d’un paysage de plus en plus complexe d’outils de gestion de données, de scripts et de traitements d’analyse à gérer et coordonner. C’est…

Par COINTEPAS Aargan

5 mai 2020

Comparaison de différents formats de fichier en Big Data

Catégories : Big Data, Data Engineering | Tags : Business Intelligence, Data structures, Avro, HDFS, ORC, Parquet, Traitement par lots, Big Data, CSV, JavaScript Object Notation (JSON), Kubernetes, Protocol Buffers

Dans l’univers du traitement des données, il existe différents types de formats de fichiers pour stocker vos jeu de données. Chaque format a ses propres avantages et inconvénients selon les cas d…

Par NGOM Aida

23 juil. 2020

Téléchargement de jeux de données dans HDFS et Hive

Catégories : Big Data, Data Engineering | Tags : Business Intelligence, Data Engineering, Data structures, Base de données, Hadoop, HDFS, Hive, Big Data, Analyse de données, Data Lake, Lakehouse, Entrepôt de données (Data Warehouse)

Introduction De nos jours, l’analyse de larges quantités de données devient de plus en plus possible grâce aux technologies du Big data (Hadoop, Spark,…). Cela explique l’explosion du volume de…

Par NGOM Aida

31 juil. 2020

Reconstruction de Hive dans HDP : patch, test et build

Catégories : Big Data, Infrastructure | Tags : Maven, GitHub, Java, Hive, Git, Versions et évolutions, TDP, Tests unitaires

La distribution HDP d’Hortonworks va bientôt être dépreciée a profit de la distribution CDP proposée par Cloudera. Un client nous a demandé d’intégrer d’une nouvelle feature de Apache Hive sur son…

Par SCHOUKROUN Leo

6 oct. 2020

Construire votre distribution Big Data open source avec Hadoop, Hive, HBase, Spark et Zeppelin

Catégories : Big Data, Infrastructure | Tags : Maven, Hadoop, HBase, Hive, Spark, Git, Versions et évolutions, TDP, Tests unitaires

L’écosystème Hadoop a donné naissance à de nombreux projets populaires tels que HBase, Spark et Hive. Bien que des technologies plus récentes commme Kubernetes et les stockages objets compatibles S…

Par SCHOUKROUN Leo

18 déc. 2020

Espace de stockage et temps de génération des formats de fichiers

Catégories : Data Engineering, Data Science | Tags : Avro, HDFS, Hive, ORC, Parquet, Big Data, Data Lake, Format de fichier, JavaScript Object Notation (JSON)

Le choix d’un format de fichier approprié est essentiel, que les données soient en transit ou soient stockées. Chaque format de fichier a ses avantages et ses inconvénients. Nous les avons couverts…

Par NGOM Barthelemy

22 mars 2021

H2O en pratique: retour d'expérience d'un Data Scientist

Catégories : Data Science, Formation | Tags : Automation, Cloud, H2O, Machine Learning, MLOps, On-premises, Open source, Python

Les plates-formes d’apprentissage automatique (AutoML) gagnent en popularité et deviennent un outil puissant à disposition des data scientists. Il y a quelques mois, j’ai présenté H2O, une plate-forme…

29 sept. 2021

Stage de fin d'étude printemps 2022 en Data Engineering

Catégories : Front End, Formation | Tags : Métriques, Supervision, Hadoop, Hive, Kafka, Delta Lake, Elasticsearch, IaC, Internship, Kubernetes, MLflow, Prometheus, Streaming, TFX

Descriptif du stage La donnée est un actif précieux des entreprises. Le data engineer collecte, convertit et valorise la donnée brute en une information exploitable par les business analysts et les…

Par WORMS David

25 oct. 2021

H2O en pratique : un protocole combinant AutoML et les approches de modélisation traditionnelles

Catégories : Data Science, Formation | Tags : Automation, Cloud, H2O, Machine Learning, MLOps, On-premises, Open source, Python, XGBoost

H20 est livré avec de nombreuses fonctionnalités. La deuxième partie de la série H2O en pratique propose un protocole pour combiner la modélisation AutoML avec des approches de modélisation et d…

12 nov. 2021

Développement accéléré de modèles avec H2O AutoML et Flow

Catégories : Data Science, Formation | Tags : Automation, Cloud, H2O, Machine Learning, MLOps, On-premises, Open source, Python

La construction de modèles de Machine Learning (ML) est un processus très consommateur de temps. De plus, il requière de bonne connaissance en statistique, en algorithme de ML ainsi qu’en…

10 déc. 2020

Stage en infrastructure Big Data avec TDP

Catégories : Infrastructure, Formation | Tags : Cybersécurité, DevOps, Java, Ansible, Hadoop, Internship, TDP

Le Big Data et l’informatique distribuée sont au cœur d’Adaltas. Nous accompagnons nos partenaires dans le déploiement, la maintenance et l’optimisation de certains des plus grands clusters de France…

Par HARTY Daniel

25 oct. 2021

Comparaison des architectures de base de données : data warehouse, data lake and data lakehouse

Catégories : Big Data, Data Engineering | Tags : Gouvernance des données, Infrastructure, Iceberg, Parquet, Spark, Data Lake, Lakehouse, Entrepôt de données (Data Warehouse), Format de fichier

Les architectures de base de données ont fait l’objet d’une innovation constante, évoluant avec l’apparition de nouveaux cas d’utilisation, de contraintes techniques et d’exigences. Parmi les trois…

17 mai 2022

CDP partie 6 : cas d'usage bout en bout d'un Data Lakehouse avec CDP

Catégories : Big Data, Data Engineering, Formation | Tags : Business Intelligence, Data Engineering, Iceberg, NiFi, Spark, Big Data, Cloudera, CDP, Analyse de données, Data Lake, Entrepôt de données (Data Warehouse)

Dans cet exercice pratique, nous montrons comment construire une solution big data complète avec la Cloudera Data Platform (CDP) Public Cloud, en se basant sur l’infrastructure qui a été déployée tout…

Par CHAVARRIA Tobias

24 juil. 2023