Articles publiés en 2019

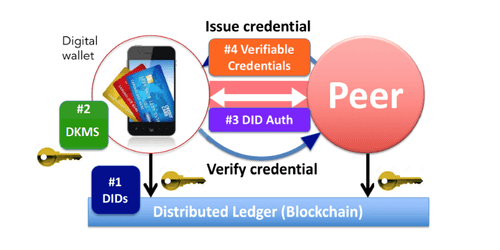

Les identités auto-souveraines

Catégories : Gouvernance des données | Tags : GitHub, Authentification, Blockchain, Cloud, GitLab, IAM, Livre de compte (ledger)

Vers une identité numérique fiable, personnelle, persistante et portable pour tous. Problèmes d’identité numérique Les identités auto-souveraines sont une tentative de redéfinir le notion d’identité…

Par MELLAL Nabil

23 janv. 2019

Installation de Kubernetes sur CentOS 7

Catégories : Orchestration de conteneurs | Tags : CentOS, cgroups, DevOps, Infrastructure, Namespaces, Red Hat, VM, Ceph, CNCF, Docker, Kubernetes

Cet article présente la démarche à suivre afin d’installer un cluster Kubernetes. Chaque étape sera détaillée afin que ayez une compréhension approfondie de chacune d’elle. Cet article s’appuie sur ma…

Par BUSSER Arthur

29 janv. 2019

Apprentissage par renforcement appliqué au jeu de Poker

Catégories : Data Science | Tags : Algorithme, Jeu, Q-learning, Deep Learning, Machine Learning, Réseau de neurones, Python

Dans cet article, nous présenterons le “Deep Reinforcement Learning”, et plus particulièrement l’algorithme de Deep Q Learning introduit par DeepMind il y a quelques années. Dans une seconde partie…

9 janv. 2019

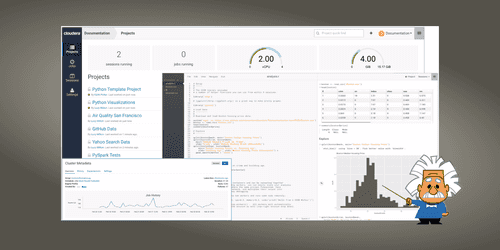

Introduction à Cloudera Data Science Workbench

Catégories : Data Science | Tags : Performance, Azure, Azure Data Catalog, Azure Data Factory, Cloud, Cloudera, Data Hub, Docker, Git, Kubernetes, Machine Learning, MLOps, Notebook

Cloudera Data Science Workbench est une plateforme qui permet aux Data Scientists de créer, gérer, exécuter et planifier des workflows de Data Science à partir de leur navigateur. Cela leur permet…

Par ELALAMI Mehdi

28 févr. 2019

Apache Knox, c'est facile !

Catégories : Big Data, Cybersécurité, Adaltas Summit 2018 | Tags : Ambari, Ranger, Shiro, Solr, JDBC, LDAP, Active Directory, Hadoop, Hive, Knox, Kerberos, Log4j, REST, SSL/TLS, SSO

Apache Knox est le point d’entrée sécurisé d’un cluster Hadoop, mais peut-il être également le point d’entrée de mes applications REST ? Vue d’ensemble d’Apache Knox Apache Knox est une passerelle…

Par HATOUM Michael

4 févr. 2019

Publier Spark SQL Dataframe et RDD avec Spark Thrift Server

Catégories : Data Engineering | Tags : Thrift, JDBC, Hadoop, Hive, Spark, Python, SQL

La nature distribuée et en-mémoire du moteur de traitement Spark en fait un excellant candidat pour exposer des données à des clients qui souhaitent des latences faibles. Les dashboards, les notebooks…

Par RYNKIEWICZ Oskar

25 mars 2019

Multihoming avec Hadoop

Catégories : Infrastructure | Tags : Hadoop, HDFS, Kerberos, Réseau

Le multihoming, qui implique l’association de plusieurs réseaux à un nœud, permet de gérer l’utilisation de réseaux hétérogènes dans un cluster Hadoop. Cet article est une introduction au concept de…

Par RUMMENS Joris

5 mars 2019

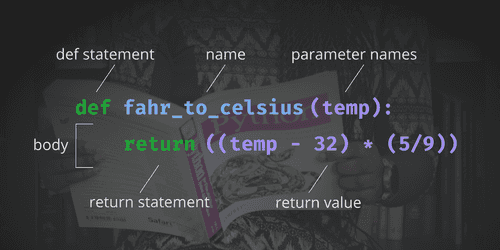

Les fonctions de première classe en Python

Catégories : Hack, Formation | Tags : Programmation, Python

J’ai récemment regardé une conférence de Dave Cheney sur les fonctions de première classe en Go. Sachant que Python est également capable de les prendre en charge, sont-elles utilisables de la même…

Par BUSSER Arthur

15 avr. 2019

Réinstaller une partition EFI sur un serveur dédié

Catégories : Hack | Tags : Infrastructure, Linux, Cloud

Nous avons récemment eu quelques difficultés avec la partition EFI d’un serveur dédié. Après un redémarrage, il n’est pas revenu en ligne. Si vous avez un serveur dédié chez votre hébergeur, vous êtes…

Par JOUET Grégor

16 avr. 2019

Gatbsy.js, React et GraphQL pour nos documentations

Catégories : Adaltas Summit 2018, Front End | Tags : Gatsby, HTTP, JAMstack, React.js, SEO, API, GitOps, GraphQL, IaC, JavaScript, Markdown, Node.js

Au cours des derniers mois, j’ai consacrer un peu de temps à la ré-écritures de quelques sites Web pour nos projets Open Source. Ces sites incluent le projet CSV de Node.js, le client HBase pour Node…

Par WORMS David

1 avr. 2019

Notes du Google Cloud Summit à Paris

Catégories : Évènements | Tags : AWS, Azure, Cloud, GCP, Kubernetes, On-premises

Le 18 Juin avait lieu l’édition 2019 du salon annuel de Google à Paris. L’édition Parisienne de cette année a été la plus grande jusqu’à maintenant, ce qui reflète l’engagement de Google à se…

Par SAHNOUNI Tariq

26 juin 2019

Intégration de Druid et Hive

Catégories : Big Data, Business Intelligence, Tech Radar | Tags : Druid, Enseignement et tutorial, LLAP, OLAP, Hive, Analyse de données, GitLab, PostgreSQL, SQL

Nous allons dans cet article traiter de l’intégration entre Hive Interactive (LLAP) et Druid. Cet article est un complément à l’article Ultra-fast OLAP Analytics with Apache Hive and Druid.…

Par SAUVAGE Pierre

17 juin 2019

Apache Hive 3, nouvelles fonctionnalités et conseils et astuces

Catégories : Big Data, Business Intelligence, DataWorks Summit 2019 | Tags : Druid, JDBC, LLAP, Active Directory, Hadoop, Hive, Kafka, Cloudera, Entrepôt de données (Data Warehouse), PostgreSQL, Python, Versions et évolutions, Storage

Disponible depuis juillet 2018 avec HDP3 (Hortonworks Data Platform 3), Apache Hive 3 apporte de nombreuses fonctionnalités intéressantes à l’entrepôt de données. Malheureusement, comme beaucoup de…

Par LEONARD Gauthier

25 juil. 2019

Activer Aladdin eToken dans Firefox sur Archlinux

Catégories : Hack | Tags : Arch Linux, Cybersécurité, Firefox, sécurité, Carte à puce, 2FA

Si comme moi vous êtes sur Archlinux et que vous disposez d’un eToken Aladdin pour vous authentifier, voyons comment nous pouvons le monter dans Firefox pour l’authentification Web. Un eToken Aladdin…

Par BEREZOWSKI César

12 juil. 2019

Installation de TensorFlow avec Docker

Catégories : Orchestration de conteneurs, Data Science, Formation | Tags : CPU, Linux, IA, Deep Learning, Docker, Jupyter, Python, TensorFlow

TensorFlow est un logiciel open source de Google pour le calcul numérique utilisant une représentation en graph : Vertex (nodes) représentent des opérations mathématiques Edges représentent un tableau…

Par SAUVAGE Pierre

5 août 2019

Rook via Ceph n'approvisionne pas mes Persistent Volume Claims !

Catégories : DevOps & SRE | Tags : PVC, Linux, Rook, Ubuntu, Ceph, Cluster, Internship, Kubernetes, PostgreSQL, Redis, Storage

L’installation de Ceph dans un cluster Kubernetes peut être automatisé par l’utilisation de Rook. Actuellement en stage chez Adaltas, j’étais en charge de participer à la configuration d’un cluster…

Par CHOJNOWSKI Eyal

9 sept. 2019

Auto-scaling de Druid avec Kubernetes

Catégories : Big Data, Business Intelligence, Orchestration de conteneurs | Tags : EC2, Druid, Helm, Métriques, OLAP, Exploitation, Orchestration de conteneurs, Cloud, CNCF, Analyse de données, Kubernetes, Prometheus, Python

Apache Druid est un système de stockage de données open-source destiné à l’analytics qui peut profiter des capacités d’auto-scaling de Kubernetes de par son architecture distribuée. Cet article est…

Par SCHOUKROUN Leo

16 juil. 2019

Utilisateurs et autorisations RBAC dans Kubernetes

Catégories : Orchestration de conteneurs, Gouvernance des données | Tags : Cybersécurité, RBAC, Authentification, Autorisation, Kubernetes, SSL/TLS

Le déploiement d’un cluster Kubernetes n’est que le début de votre parcours et vous devez maintenant l’exploiter. Pour sécuriser son accès, les identités des utilisateurs doivent être déclarées avec…

7 août 2019

Notes sur le nouveau modèle de licences Open Source de Cloudera

Catégories : Big Data | Tags : CDSW, Licence, Cloudera, CDH, Cloudera Manager, HDP, Open source

Suite à la publication de sa stratégie de licences Open Source le 10 juillet 2019 dans un article intitulé “notre engagement envers les logiciels Open Source”, Cloudera a diffusé un webinaire hier le…

Par WORMS David

25 oct. 2019

Authentification Kerberos et Spnego sur Windows avec Firefox

Catégories : Cybersécurité | Tags : Cryptographie, DevOps, Firefox, HTTP, Big Data, FreeIPA, Kerberos, Réseau

Dans la mythologie grecque, Kerberos, aussi appelé Cerbère, garde les portes du monde souterrain pour empêcher les morts de partir. Il est communément décrit comme un chien à trois têtes ayant une…

Par WORMS David

4 nov. 2019

Mise en production d'un modèle de Machine Learning

Catégories : Big Data, Data Engineering, Data Science, DevOps & SRE | Tags : C++, DevOps, Java, Supervision, Exploitation, IA, Hadoop, Kafka, Spark, YARN, Cloud, Conteneur, Deep Learning, Docker, Kubernetes, Machine Learning, MLflow, MLOps, Réseau de neurones, On-premises, Python, Schéma, TensorFlow, XGBoost

“Le Machine Learning en entreprise nécessite une vision globale […] du point de vue de l’ingénierie et de la plateforme de données”, a expliqué Justin Norman lors de son intervention sur le…

Par RYNKIEWICZ Oskar

30 sept. 2019

Éviter les blocages dans les pipelines distribués de Deep Learning avec Horovod

Catégories : Data Science | Tags : Algorithme, CPU, GPU, Pipeline, Performance, Deep Learning, Horovod, Keras, Machine Learning, TCO, TensorFlow

L’entraînement des modèles Deep Learning peut être grandement accéléré en utilisant un cluster de GPUs. Lorsqu’il s’agit de grandes quantités de données, effectuer des calculs distribués devient…

Par JOUET Grégor

15 nov. 2019

Stage Data Science & Data Engineer - ML en production et ingestion streaming

Catégories : Data Engineering, Data Science | Tags : Automation, DevOps, Enseignement et tutorial, Flink, Hadoop, HBase, Kafka, Spark, Big Data, Conteneur, Elasticsearch, Internship, Kubernetes, NoSQL, Python

Contexte L’évolution exponentielle des données a bouleversé l’industrie en redéfinissant les méthodes de stockages, de traitement et d’acheminement des données. Maitriser ces méthodes facilite…

Par WORMS David

26 nov. 2019

Hadoop Ozone partie 1: introduction du nouveau système de fichiers

Catégories : Infrastructure | Tags : Container Storage Interface (CSI), HDFS, Hive, MapReduce, Ozone, Spark, Amazon S3, Big Data, Cloud, Cluster, Kubernetes, Versions et évolutions

Hadoop Ozone est système de stockage d’objet pour Hadooop. Il est conçu pour supporter des milliards d’objets de tailles diverses. Il est actuellement en développement. La feuille de route est…

3 déc. 2019

Insérer des lignes dans une table BigQuery avec des colonnes complexes

Catégories : Cloud computing, Data Engineering | Tags : Business Intelligence, Enseignement et tutorial, Big Data, GCP, BigQuery, Schéma, SQL

Le service BigQuery de Google Cloud est une solution data warehouse conçue pour traiter d’énormes volumes de données avec un certain nombre de fonctionnalités disponibles. Parmi toutes celles-ci, nous…

Par BEREZOWSKI César

22 nov. 2019

Hadoop Ozone partie 3: Stratégie de réplication avancée avec les Copyset

Catégories : Infrastructure | Tags : HDFS, Ozone, Amazon S3, Big Data, Cloud, Cluster, Kubernetes, Noeud, Versions et évolutions

Hadoop Ozone propose de configurer le type de réplication à chaque écriture effectué sur le cluster. Actuellement seules HDFS et Ratis sont disponibles mais des stratégies plus avancées sont…

3 déc. 2019

Hadoop Ozone partie 2: tutorial et démonstration des fonctionnalités

Catégories : Infrastructure | Tags : CLI, HTTP, Enseignement et tutorial, HDFS, Ozone, Amazon S3, Big Data, Cloud, Cluster, Kerberos, Versions et évolutions, REST

Les versions d’Hadoop Ozone sont livrées avec des fichiers docker-compose très pratique pour tester Ozone. Les instructions ci-dessous apportent des détails sur comment les utiliser. Il est aussi…

3 déc. 2019

Migration Big Data et Data Lake vers le Cloud

Catégories : Big Data, Cloud computing | Tags : DevOps, Hadoop, Kafka, Knox, Spark, AWS, Amazon S3, Azure, Azure Data Lake Storage (ADLS), Azure Data Catalog, Azure Data Factory, Cloud, CDP, Data Hub, Databricks, GCP, Kubernetes, Redis

Est-il impératif de suivre tendance et de migrer ses données, workflow et infrastructure vers l’un des Cloud providers tels que GCP, AWS ou Azure ? Lors de la Strata Data Conference à New-York, un…

Par RUMMENS Joris

9 déc. 2019

Configuration à distance et auto-indexage des pipelines Logstash

Catégories : Data Engineering, Infrastructure | Tags : DevOps, Pipeline, Conteneur, Docker, Elasticsearch, Kibana, Logstash, Log4j

Logstash est un puissant moteur de collecte de données qui s’intègre dans la suite Elastic (Elasticsearch - Logstash - Kibana). L’objectif de cet article est de montrer comment déployer un cluster…

13 déc. 2019

Spark Streaming partie 1 : construction de data pipelines avec Spark Structured Streaming

Catégories : Data Engineering, Formation | Tags : PySpark, Apache Spark Streaming, Kafka, Spark, Big Data, SQL, Streaming

Spark Structured Streaming est un nouveau moteur de traitement stream introduit avec Apache Spark 2. Il est construit sur le moteur Spark SQL et utilise le modèle Spark DataFrame. Le moteur Structured…

Par RYNKIEWICZ Oskar

18 avr. 2019

Spark Streaming partie 3 : DevOps, outils et tests pour les applications Spark

Catégories : Big Data, Data Engineering, DevOps & SRE | Tags : Apache Spark Streaming, DevOps, Enseignement et tutorial, Spark, IaC, Log4j, Python, Scala, Streaming, Tests unitaires

L’indisponibilité des services entraîne des pertes financières pour les entreprises. Les applications Spark Streaming ne sont pas exempts de pannes, comme tout autre logiciel. Une application…

Par RYNKIEWICZ Oskar

31 mai 2019

Spark Streaming Partie 2 : traitement d'une pipeline Spark Structured Streaming dans Hadoop

Catégories : Data Engineering, Formation | Tags : Apache Spark Streaming, Gouvernance des données, Hadoop, Spark, Big Data, Consensus, Format de fichier, Python, Streaming, TCO

Spark est conçu pour traiter des données streaming de manière fluide sur un cluster Hadoop multi-nœuds, utilisant HDFS pour le stockage et YARN pour l’orchestration de tâches. Ainsi, Spark Structured…

Par RYNKIEWICZ Oskar

28 mai 2019

Spark Streaming partie 4 : clustering avec Spark MLlib

Catégories : Data Engineering, Data Science, Formation | Tags : Apache Spark Streaming, Spark, Big Data, Clustering, Machine Learning, Scala, Streaming

Spark MLlib est une bibliothèque Spark d’Apache offrant des implémentations performantes de divers algorithmes d’apprentissage automatique supervisés et non supervisés. Ainsi, le framework Spark peut…

Par RYNKIEWICZ Oskar

27 juin 2019

Cloudera CDP et migration Cloud de votre Data Warehouse

Catégories : Big Data, Cloud computing | Tags : EC2, Ranger, Atlas, Knox, Spark, AWS, Amazon S3, Azure, Azure Data Lake Storage (ADLS), Cloudera, Data Hub, Data Lake, Entrepôt de données (Data Warehouse), FreeIPA, Keycloak

Alors que l’un de nos clients anticipe un passage vers le Cloud et avec l’annonce récente de la disponibilité de Cloudera CDP mi-septembre lors de la conférence Strata, il semble que le moment soit…

Par WORMS David

16 déc. 2019

Stage InfraOps & DevOps - construction d'une offre PaaS Big Data & Kubernetes

Catégories : Big Data, Orchestration de conteneurs | Tags : Automation, Data Engineering, DevOps, Enseignement et tutorial, LXD, Hadoop, Kafka, Spark, Ceph, Git, IaC, Internship, Kubernetes, NoSQL

Contexte L’acquisition d’un cluster à forte capacité répond à la volonté d’Adaltas de construire une offre de type PAAS pour disposer et mettre à disposition des plateformes de Big Data et d…

Par WORMS David

26 nov. 2019

Innovation, culture projet vs culture produit en Data Science

Catégories : Data Science, Gouvernance des données | Tags : DevOps, Agile, Registre, Schéma, Scrum, TCO

La Data Science porte en elle le métier de demain. Elle est étroitement liée à la compréhension du métier, des comportements et de l’intelligence qu’on tirera des données existantes. Les enjeux sont à…

Par WORMS David

8 oct. 2019